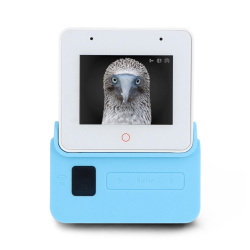

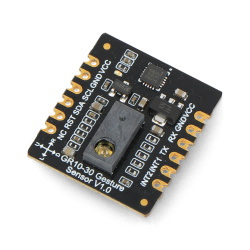

Opis produktu: LLM - moduł wnioskowania offline - AX630C - do modułów deweloperskich M5Core - M5Stack M140

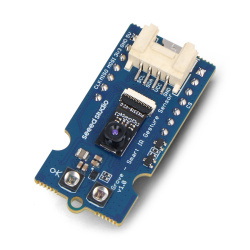

M5Stack LLM to kompaktowy moduł inferencyjny AI przeznaczony do zastosowań brzegowych, wymagających inteligentnej obsługi językowej i głosowej w trybie offline. Dzięki wydajnemu procesorowi AX630C z wbudowanym NPU oraz preinstalowanemu modelowi Qwen2.5-0.5B, moduł umożliwia płynną obsługę zadań LLM, takich jak rozpoznawanie mowy, synteza głosu czy analiza języka naturalnego. Obsługuje pracę z wieloma modelami równocześnie, a jego niski pobór mocy (1,5 W przy pełnym obciążeniu) sprawia, że nadaje się do pracy ciągłej. Moduł posiada mikrofon, głośnik, diodę RGB, gniazdo na kartę microSD oraz złącze USB OTG, co czyni go wszechstronnym rozwiązaniem dla projektów AI i IoT.

Sprawdź także przewodnik użytkownika przygotowany przez producenta!

Główne cechy modułu LLM

- Wydajna inferencja offline: 3,2 TOPS przy precyzji INT8, wsparcie dla modeli Transformer

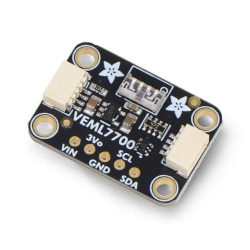

- Obsługa wielu funkcji AI: KWS (wake word), ASR (rozpoznawanie mowy), LLM (model językowy), TTS (synteza mowy)

- Duża pamięć operacyjna i masowa: 4 GB LPDDR4 (1 GB użytkowe) oraz 32 GB eMMC

- Wbudowane elementy audio: mikrofon MSM421A oraz głośnik 8 Ω 1 W

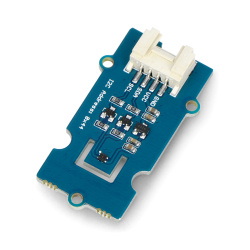

- Wszechstronna komunikacja: interfejs UART oraz port USB z automatycznym przełączaniem master / slave

- Wsparcie dla aktualizacji firmware: poprzez kartę SD oraz port USB typu C

- Wskaźnik stanu pracy: 3 diody RGB LED sterowane przez LP5562

- Niskie zużycie energii: 0,5 W w spoczynku, 1,5 W przy pełnym obciążeniu

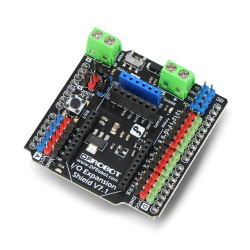

Kompatybilność i możliwości programowania

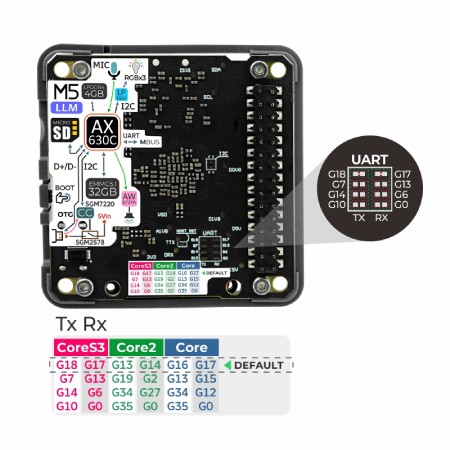

Moduł LLM został zaprojektowany z myślą o pełnej zgodności z rodziną M5Stack Core, jak Core Basic, Core2 oraz CoreS3. Obsługuje bezproblemową integrację plug and play z wykorzystaniem interfejsów UART. Programowanie jest możliwe zarówno za pomocą środowiska Arduino IDE, jak i platformy graficznej UiFlow2, co umożliwia łatwe wdrożenie nawet bez zaawansowanej wiedzy programistycznej. Dzięki integracji z frameworkiem StackFlow, możliwe jest szybkie budowanie aplikacji AI opartych na interakcji głosowej i przetwarzaniu języka naturalnego.

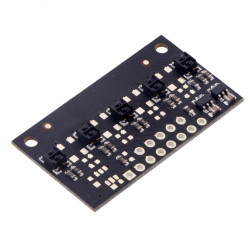

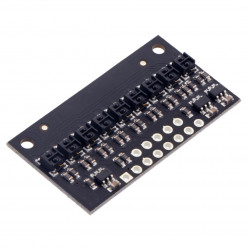

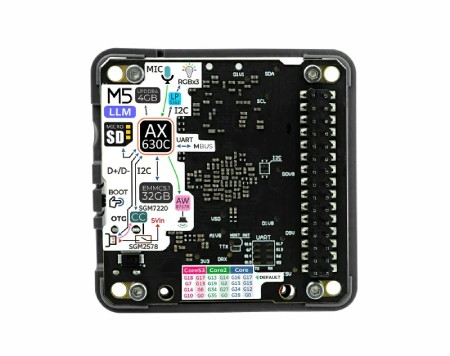

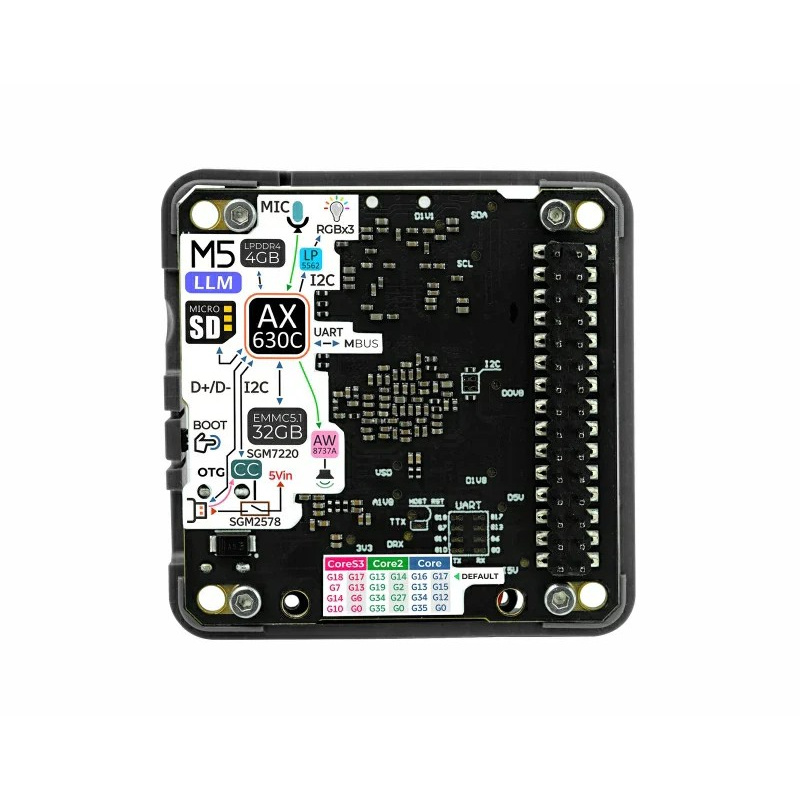

W przypadku konfliktów wynikających ze współdzielenia pinów, możliwe jest przecięcie ścieżki na płytce PCB i połączenie jej z innym zestawem pinów za pomocą zworki.

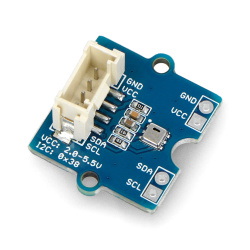

W przypadku konfliktów wynikających ze współdzielenia pinów, możliwe jest przecięcie ścieżki na płytce PCB i połączenie jej z innym zestawem pinów za pomocą zworki.Wyprowadzenia i sposób podłączenia

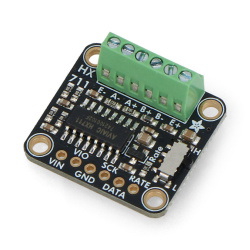

Moduł M5Stack LLM komunikuje się przez port UART, a domyślne piny transmisji można konfigurować dzięki padom przełączającym na płytce PCB. Możesz wybrać jedną z kilku linii GPIO w zależności od kompatybilnego hosta (np. Core2, CoreS3), przecinając ścieżkę i łącząc wybrany pin. Dzięki temu unika się konfliktów sygnałowych. Dla CoreS3 domyślne piny to: TX - G18, RX - G17. Zasilanie dostarczane jest przez port USB typu C (5 V), który służy również do aktualizacji firmware’u i podłączania urządzeń peryferyjnych, takich jak kamera. Wskaźniki RGB informują o stanie pracy i aktualizacji aplikacji.

Zastosowania w praktyce

- Asystenci głosowi offline do sterowania urządzeniami inteligentnego domu

- Systemy syntezy mowy w urządzeniach interaktywnych

- Roboty edukacyjne i przemysłowe z interfejsem głosowym

- Terminale sterujące w przemyśle i logistyce z AI

- Zastosowania AI bez dostępu do Internetu, gdzie wymagana jest prywatność danych

Specyfikacja techniczna modułu

- Procesor: AX630C (Dual Cortex A53, taktowanie 1,2 GHz)

- NPU: 12,8 TOPS przy INT4, 3,2 TOPS przy INT8

- Pamięć RAM: 4 GB LPDDR4 (1 GB system, 3 GB akceleracja)

- Pamięć Flash: 32 GB eMMC 5.1

- Interfejs komunikacyjny: UART, domyślna prędkość 115200 bps przy 8N1 (regulowana)

- Porty aktualizacji: gniazdo karty microSD / port USB typu C

- Mikrofon: MSM421A

- Głośnik: 8 Ω przy 1 W

- Wskaźniki: 3x RGB LED sterowane przez LP5562

- Wbudowane funkcje AI: KWS, ASR, LLM, TTS

- Zużycie energii: 0,5 W (w spoczynku), 1,5 W (przy pełnym obciążeniu)

- Temperatura pracy: od 0 do 40°C

- Wymiary: 54 x 54 x 13 mm

- Masa: 17,1 g

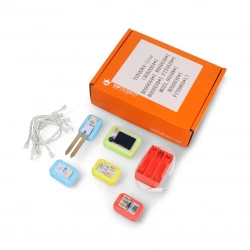

Zawartość zestawu

- 1x Moduł LLM