- Produkt wycofany

|

Uwaga! Sprzedaż produktu została zakończona. Sprawdź inne w tej kategorii. |

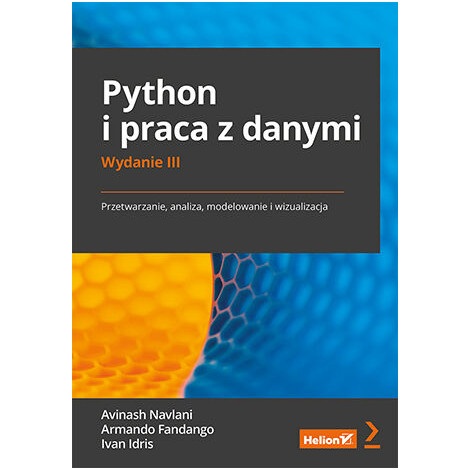

Opis produktu: Python i praca z danymi. Przetwarzanie, analiza, modelowanie i wizualizacja. Wydanie III - Avinash Navlani, Armando Fandango, Ivan Idris

Książka zawiera wszystkie potrzebne informacje i umiejętności, aby skutecznie używać Pythona do analizy danych. Przedstawia niezbędne podstawy statystyki i zasady analizy danych, zaawansowane zagadnienia dotyczące przygotowania, przetwarzania i modelowania danych, a także ich wizualizacji. W zrozumiały sposób wyjaśnia takie procesy jak inteligentne przetwarzanie i analizowanie danych za pomocą algorytmów uczenia maszynowego: regresji, klasyfikacji, analizy głównych składowych czy analizy skupień. Podręcznik składa się z praktycznych przykładów przetwarzania języka naturalnego i analizy obrazów, przeznaczony jest dla przyszłych programistów.

Informacje o autorach

Avinash Navlani - wykładowca akademicki, obecnie wdraża narzędzia do analizy danych wielkoskalowych i tworzenia modeli. Angażuje się w projekty badawcze.

Armando Fandango - specjalizuje się w dziedzinie głębokiego uczenia, uczenia maszynowego, rozproszonego przetwarzania danych i metod obliczeniowych. Konsultant, projektant i autor książek.

Ivan Idris - programista, twórca hurtowni danych i analitykiem biznesu. Słynie ze schludnego kodu i z interesującego sposobu pisania.

Informacje o książce

- Tytuł oryginału: Python Data Analysis: Perform data collection, data processing, wrangling, visualization, and model building using Python, 3rd Edition

- Autorzy: Avinash Navlani, Armando Fandango, Ivan Idris

- Tłumaczenie: Krzysztof Sawka

- ISBN: 978-83-283-8360-9

- Data wydania: 26.04.2022 r.

- Format: 168 x 237 mm

- Oprawa: miękka

- Ilość stron: 384

- Wydawnictwo: Helion S.A.

Spis treści

Współautorzy

Wstęp

Część I. Podstawy analizy danych

-

- Rozdział 1. Wprowadzenie do bibliotek Pythona

- Wyjaśnienie pojęcia "analiza danych"

- Standardowy proces analizy danych

- Proces KDD

- Proces SEMMA

- Proces CRISP-DM

- Analiza danych a danetyka

- Umiejętności analityka danych oraz danetyka

- Instalacja środowiska Python 3

- Oprogramowanie używane w tej książce

- Używanie aplikacji IPython jako powłoki

- Korzystanie z aplikacji JupyterLab

- Stosowanie aplikacji Jupyter Notebook

- Zaawansowane funkcje aplikacji Jupyter Notebook

- Podsumowanie

- Rozdział 2. Biblioteki NumPy i pandas

- Wymogi techniczne

- Tablice NumPy

- Numeryczne typy danych tablic NumPy

- Manipulowanie wymiarami tablic

- Łączenie tablic NumPy

- Rozdzielanie tablic NumPy

- Zmiana typu danych tablic NumPy

- Tworzenie widoków i kopii NumPy

- Fragmentowanie tablic NumPy

- Indeksowanie logiczne i indeksowanie specjalne

- Rozgłaszanie tablic

- Tworzenie obiektów DataFrame biblioteki pandas

- Obiekt Series biblioteki pandas

- Odczytywanie i kwerendowanie danych Quandl

- Opisywanie obiektów DataFrame

- Grupowanie i złączanie obiektów DataFrame

- Praca z brakującymi danymi

- Tworzenie tabel przestawnych

- Rozwiązywanie kwestii dat

- Podsumowanie

- Bibliografia

- Rozdział 3. Statystyka

- Wymogi techniczne

- Atrybuty i ich typy

- Pomiar tendencji centralnej

- Pomiar dyspersji

- Skośność i kurtoza

- Określanie związków za pomocą współczynników kowariancji i korelacji

- Centralne twierdzenie graniczne

- Pozyskiwanie prób

- Przeprowadzanie testów parametrycznych

- Przeprowadzanie testów nieparametrycznych

- Podsumowanie

- Rozdział 4. Algebra liniowa

- Wymogi techniczne

- Dopasowywanie do wielomianów za pomocą biblioteki NumPy

- Wyznacznik macierzy

- Określanie rzędu macierzy

- Macierz odwrotna w bibliotece NumPy

- Rozwiązywanie równań liniowych za pomocą biblioteki NumPy

- Rozkład macierzy za pomocą SVD

- Wartości własne i wektory własne w bibliotece NumPy

- Generowanie liczb losowych

- Rozkład dwumianowy

- Rozkład normalny

- Testowanie normalności rozkładu danych za pomocą biblioteki SciPy

- Tworzenie tablicy maskowanej za pomocą podpakietu numpy.ma

- Podsumowanie

- Rozdział 1. Wprowadzenie do bibliotek Pythona

Część II. Eksploracyjna analiza danych i oczyszczanie danych

-

- Rozdział 5. Wizualizacja danych

- Wymogi techniczne

- Wizualizacja za pomocą pakietu Matplotlib

- Zaawansowana wizualizacja za pomocą pakietu seaborn

- Wizualizacja interaktywna za pomocą biblioteki Bokeh

- Podsumowanie

- Rozdział 6. Pozyskiwanie, przetwarzanie i przechowywanie danych

- Wymogi techniczne

- Odczyt i zapis plików CSV za pomocą biblioteki NumPy

- Odczyt i zapis plików CSV za pomocą biblioteki pandas

- Odczyt i zapis plików arkusza kalkulacyjnego Excel

- Odczyt i zapis plików JSON

- Odczyt i zapis plików HDF5

- Odczyt i zapis danych z tabel HTML-a

- Odczyt i zapis plików Parquet

- Odczyt i zapis danych z obiektu pickle

- Łatwy dostęp do danych za pomocą modułu sqlite3

- Odczyt i zapis danych w bazie danych MySQL

- Odczyt i zapis danych w bazie danych MongoDB

- Odczyt i zapis danych w bazie danych Cassandra

- Odczyt i zapis danych w bazie danych Redis

- PonyORM

- Podsumowanie

- Rozdział 7. Oczyszczanie nieuporządkowanych danych

- Wymogi techniczne

- Eksploracja danych

- Filtrowanie danych w celu pozbycia się szumu

- Rozwiązywanie kwestii brakujących wartości

- Rozwiązywanie kwestii elementów odstających

- Techniki kodowania cech

- Skalowanie cech

- Przekształcanie cech

- Rozdzielanie cech

- Podsumowanie

- Rozdział 8. Przetwarzanie sygnałów i szeregi czasowe

- Wymogi techniczne

- Moduł statsmodels

- Średnie kroczące

- Funkcje okna czasowego

- Kointegracja

- Rozkład STL

- Autokorelacja

- Modele autoregresyjne

- Model ARMA

- Generowanie sygnałów okresowych

- Analiza Fouriera

- Filtrowanie metodą analizy widmowej

- Podsumowanie

- Rozdział 5. Wizualizacja danych

Część III. Dokładna analiza uczenia maszynowego

-

- Rozdział 9. Uczenie nadzorowane: analiza regresyjna

- Wymogi techniczne

- Regresja liniowa

- Wielowspółliniowość

- Zmienne fikcyjne

- Projektowanie modelu regresji liniowej

- Ocenianie skuteczności modelu regresyjnego

- Dopasowywanie regresji wielomianowej

- Modele regresji używane w klasyfikacji

- Regresja logistyczna

- Implementacja regresji logistycznej za pomocą biblioteki scikit-learn

- Podsumowanie

- Rozdział 10. Uczenie nadzorowane: techniki klasyfikacji

- Wymogi techniczne

- Klasyfikacja

- Naiwny klasyfikator Bayesa

- Drzewa decyzyjne

- Algorytm KNN

- Maszyny wektorów nośnych

- Podział danych na zestawy uczący i testowy

- Ocena skuteczności modelu klasyfikacji

- Krzywa ROC i obszar AUC

- Podsumowanie

- Rozdział 11. Uczenie nienadzorowane: PCA i analiza skupień

- Wymogi techniczne

- Uczenie nienadzorowane

- Redukowanie wymiarowości danych

- Analiza głównych składowych

- Analiza skupień

- Grupowanie danych za pomocą algorytmu centroidów

- Hierarchiczna analiza skupień

- Algorytm DBSCAN

- Widmowa analiza skupień

- Ocenianie jakości analizy skupień

- Podsumowanie

- Rozdział 9. Uczenie nadzorowane: analiza regresyjna

Część IV. Przetwarzanie języka naturalnego, analiza obrazów i obliczenia równoległe

-

- Rozdział 12. Analiza danych tekstowych

- Wymogi techniczne

- Instalacja bibliotek NLTK i spaCy

- Normalizacja tekstu

- Tokenizacja

- Usuwanie słów nieinformatywnych

- Rdzeniowanie słów i lematyzacja

- Oznaczanie części mowy

- Rozpoznawanie jednostek nazewniczych

- Analiza zależności

- Tworzenie chmury słów

- "Worek słów"

- Metoda TF-IDF

- Analiza sentymentów za pomocą klasyfikacji tekstu

- Podobieństwo tekstów

- Podsumowanie

- Rozdział 13. Analiza obrazów

- Wymogi techniczne

- Instalacja biblioteki OpenCV

- Omówienie danych obrazowych

- Modele barw

- Rysowanie na obrazach

- Pisanie na obrazach

- Zmiana rozmiaru obrazu

- Przekształcenie izometryczne obrazów

- Zmiana jasności

- Rozmywanie obrazu

- Wykrywanie twarzy

- Podsumowanie

- Rozdział 14. Obliczenia równoległe za pomocą biblioteki Dask

- Obliczenia równoległe za pomocą biblioteki Dask

- Typy danych Dask

- Interfejs Dask Delayed

- Skalowane wstępne przetwarzanie danych

- Skalowane uczenie maszynowe

- Podsumowanie

- Rozdział 12. Analiza danych tekstowych

Przydatne linki |