Spis treści:

Postęp technologiczny umożliwił robotom prezentowanie emocji. Dlaczego prezentowanie, a nie okazywanie albo wyrażanie? Choć ekspresja emocjonalna jest ceniona jako pewne uzupełnienie usług, to wyrażanie prawdziwych emocji pozostaje chemiczną zagadką życia. Powiemy więcej – w interakcji człowiek-robot nawet ludzkie odczucia pozostają niezbadane. Emocje są jednak zaraźliwe, zatem kolejni konstruktorzy robotów dzięki zastosowaniu algorytmów uczenia maszynowego, biometrii i lingwistyki komputerowej szukają złotej formuły na stworzenie humanoidalnego robota idealnego. Efekt jednej z tych prób to Eva.

Czym jest robot Eva?

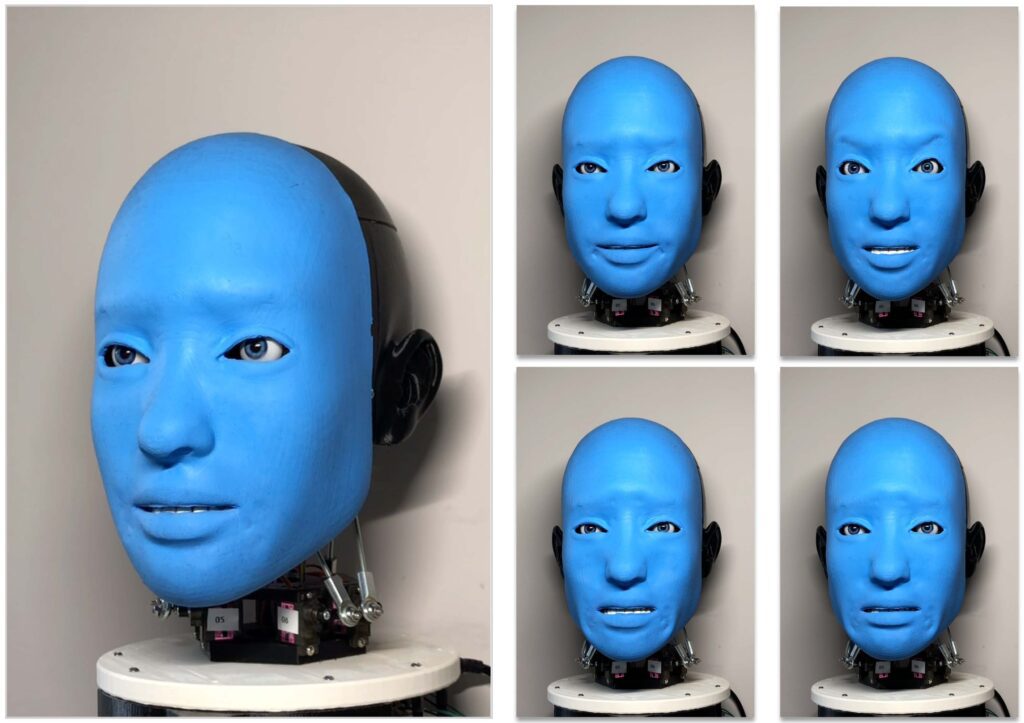

Eva to robotyczna twarz zaprojektowana w celu realistycznego odwzorowania ludzkiej mimiki i ruchów. Według zapowiedzi twórców z Creative Machines Lab z Columbia University w Nowym Jorku zostanie wykorzystana jako platforma do dalszych badań nad sztuczną inteligencją w zakresie interakcji człowiek-komputer, a w szczególności pomoże zbadać możliwości inteligencji emocjonalnej u maszyn. Wyposażono ją w 14 sztucznych mięśni skóry twarzy, 6 mięśni szyi oraz 5 mięśni gałek ocznych i powiek. Eva jest napędzana przez 25 serwomotorów MG90S i – uwaga, uwaga – sterowana przez nasze ulubione Raspberry Pi. W konstrukcji znalazł się nawet Servo Hat do RPi autorstwa znanych specjalistów od elektroniki z Adafruit. W budowie robota wykorzystano również w pewnej mierze druk 3D, a dokładniej około 2,25 kg filamentów ABS i PLA.

Według twórców Eva została zaprojektowana tak, aby można ją było wytworzyć samodzielnie za mniej niż 1000 USD – przy założeniu, że mamy dostęp do kilku standardowych narzędzi, wycinarki laserowej i drukarki 3D. Obecnie prezentowany prototyp wydrukowano na drukarce Ultimaker 2+ Extended, ale można użyć dowolnej drukarki 3D, której przestrzeń robocza oferuje co najmniej 28 cm (11 cali) wysokości.

Modelowanie zachowania

Zbadajmy głębiej robotyczne emocje. Jednak zanim to zrobimy, to musimy spojrzeć na matki i ojców robotów, czyli nas samych. O wielu zachowaniach stanowią podstawowe zdolności poznawcze, które z kolei leżą u podstaw aspektów zachowań społecznych wśród ludzi oraz zwierząt. Jasne jest, że robotycy chcieliby obdarzyć prawdziwymi zdolnościami poznawczymi swoje roboty. Jeśli sprzedawca w sklepie ustali, że konsumenci, którzy kupują szampon, zwykle kupują również mydło, ale tylko wtedy, gdy otrzymują kupon, to rozpatrzy wręczanie kuponu na mydło każdemu klientowi, zwykle kupującemu wyłącznie szampon. Dość łatwo zrozumieć ogólne założenie takiego działania. Podejście to wykorzystywane przez firmy do lepszego zrozumienia i przewidywania działań konsumentów w określonych okolicznościach. Ale co to oznacza dla robotyki? To właśnie coś, co nazywamy behavioral modelling, które obok konstruowania Evy zajmuje badaczy z Creative Machines Labs. Tylko czy to wystarczy, aby wciąż wpisywać frazę „sztuczna inteligencja” gdzie popadnie?

Prawdziwa inteligencja, prawdziwa świadomość. Bo sztuczną przecież potrafimy już stworzyć

Definicję inteligencji znajdziecie bez trudu w źródłach naukowych. Większość badań nad modelowaniem zachowania maszyn opiera się tylko na wybranych, parametrycznych danych sensorycznych (płynących z czujników, które maszyna otrzymała od swojego autora-konstruktora) i „wbudowanej” wiedzy istotnej dla danego zadania. Creative Machine Labs proponuje, by obserwator mógł modelować zachowanie maszyny poprzez jej samo przetwarzanie wzrokowe, bez wcześniejszych informacji symbolicznych i założeń dotyczących odpowiednich danych wejściowych. Aby sprawdzić tę hipotezę, specjaliści zaprojektowali niewerbalny eksperyment robotyczny, w którym obserwator AI miał przewidywać przyszłe działania aktora, bazując jedynie na obrazie przedstawiającym początkową scenę. Stwierdzono, że obserwator AI jest w stanie wizualizować przyszłe plany aktora z 98,5% powodzeniem dla czterech różnych czynności. Oczywiście podkreślono, że czynności te nie były znane AI przed eksperymentem. Creative Machine Labs zauważa, że takie wizualne modelowanie zachowania jest niezbędną zdolnością poznawczą, która pozwoli maszynom zrozumieć i koordynować działania z otaczającymi je podmiotami. Póki co AI w rywalizacji z naczelnymi nie ma na tym polu najmniejszych szans. Albo po prostu działa inaczej, czyli… nie działa jak inteligencja poznawcza.

Symbol grounding problem, czyli marzenia twórców AI

Problem symbolicznego rozumienia rzeczywistości jest związany z tym, w jaki sposób słowa (czyli symbole) uzyskują swoje znaczenia, a więc z problemem, czym tak naprawdę jest samo znaczenie. Problem znaczenia jest z kolei związany z problemem świadomości, czyli z tym, jak to się dzieje, że stany mentalne są w ogóle znaczące. Robotyka i kognitywistyka spotykają się tutaj na jednym polu. Chodzi bowiem o coś, co nazywamy intencjonalnością.

Intencjonalność to ważna umiejętność, której na razie w systemach robotycznych brakuje. Sam „program” nie może osiągnąć intencjonalności, ponieważ programy zawierają podane wcześniej relacje formalne, a intencjonalność zależy od relacji przyczynowych. Jak przezwyciężyć ograniczenia zwykłych programów? Zdaje się, że maszyny fizyczne przyczynowo połączone ze światem musiałyby posiadać wewnętrzne moce przyczynowe. Wtedy mogłyby odtwarzać konieczną przyczynowość, co jest podejściem w tym samym kierunku, w jakim podążają prace nad sztuczną inteligencją. Ważne jest, by zauważyć, że roboty nie mogą być już tylko robotami sterowanymi przez system symboli. Jeśli dane wejściowe nie pochodzą z klawiatury, nad którą siedział ktoś mądry i obeznany w podawaniu maszynie poleceń, a dane nie pochodzą wyjściowe z monitora, ale na przykład z kamery wideo (a znamy już takie próby), a następnie są przekazywane do silników, to i tak nie ma to znaczenia. System symboli nadal nie jest świadomy zmiany. I nadal w tym przypadku robot nie ma stanów intencjonalnych.

Przekonujące udawanie emocji

Zainteresowanie rozwojem kreatywnych zastosowań robotów ciągle rośnie. Mowa zwłaszcza o takich, które zapewniają rozrywkę, towarzystwo lub motywację. Identyfikacja cech charakterystycznych ludzkiej kreatywności i określenie, w jaki sposób te procesy mogą być powielane lub wspomagane przez roboty, pozostaje kwestią otwartą. Jako pasjonatów wszystkich nowoczesnych technologii cieszy nas szczególnie transdyscyplinarna współpraca pomiędzy artystami i inżynierami – Eva korzysta bowiem z minikomputera Raspberry Pi, druku 3D i osiągnięć elektroniki. Wszystko to może dać wgląd w to, w jaki sposób roboty mogą wspierać rozwój nowych ścieżek projektowania systemów interaktywnych.

Eva wyraża strach, obrzydzenie, smutek, radość i zaskoczenie. Robi to całkiem przekonująco, ale nadal jest to przetwarzanie nieintencjonalne. Problemy konstrukcyjne, opierające się na optymalnym umieszczeniu czujników w robocie, które opisują konstruktorzy, to nadal wyraz innego problemu. Owszem, Eva faktycznie uczy się – na tyle, na ile potrafimy zastosować dzięki obecnej technologii uczenie maszynowe w robotach. Ogląda nagrania przedstawiające przypadkowych ludzi wyrażających emocje, wykonuje powtórzenia ekspresji metodą prób i błędów i wreszcie coraz lepiej dopasowuje się do naturalnego sposobu wyrażania emocji. Ale to wciąż tylko dopasowywanie się. Jej smutek to nie ten sam smutek, co nasze współczucie względem humanoidalnego robota, który jest bity i kopany w fazie testów. Bo wtedy wynika to głównie z naszej natury i częściowo z realistycznych efektów pracy projektantów. Naukowcy wielu dziedzin tworzą oprogramowanie, które zapożycza pojęcia z ewolucji darwinowskiej, w tym „przetrwanie najlepiej przystosowanych”, do tworzenia programów AI, które doskonalą się z pokolenia na pokolenie bez udziału człowieka, ale to tylko technologicznie zaawansowane lalkarstwo.

Jak oceniasz ten wpis blogowy?

Kliknij gwiazdkę, aby go ocenić!

Średnia ocena: 4.3 / 5. Liczba głosów: 6

Jak dotąd brak głosów! Bądź pierwszą osobą, która oceni ten wpis.