Spis treści:

Tocząca się dyskusja na temat sztucznej inteligencji skupia się na wielu aspektach. Obok postępu naukowego nadal wiele miejsca poświęca się konsekwencji AI. Stronniczość, etyka, prywatność, bezpieczeństwo – wszystkie te kwestie są istotne, gdy mówimy o zastosowaniach opartych na AI. Wszystko sprowadza się do zaufania. Czy możemy ufać temu, co robi AI? Czy spełnia ona swoje obietnice, czy też istnieje ciemna strona?

Boom trwa na równi z naszym rosnącym entuzjazmem. Wystarczy spojrzeć na liczby. Globalna wartość rynku sztucznej inteligencji w 2021 roku jest oceniania wg Statista na 327,5 mld USD. Przychód rynku oprogramowania AI to 247,6 mld USD. Nie tylko naukowcy martwią się o wiarygodność sztucznej inteligencji. Dostawcy oprogramowania AI również chcą mieć większe zaufanie do AI. Instytut Badawczy Capgemini jako główny powód, dla którego adaptacja AI jest utrudniona, postrzega brak zaufania. Firma stwierdza: “W Capgemini wierzymy, że wartości etyczne muszą być zintegrowane z aplikacjami i procesami, które projektujemy, budujemy i wykorzystujemy. Tylko wtedy będziemy mogli stworzyć systemy AI, którym ludzie będą mogli naprawdę zaufać.”

Wyjaśnialna SI

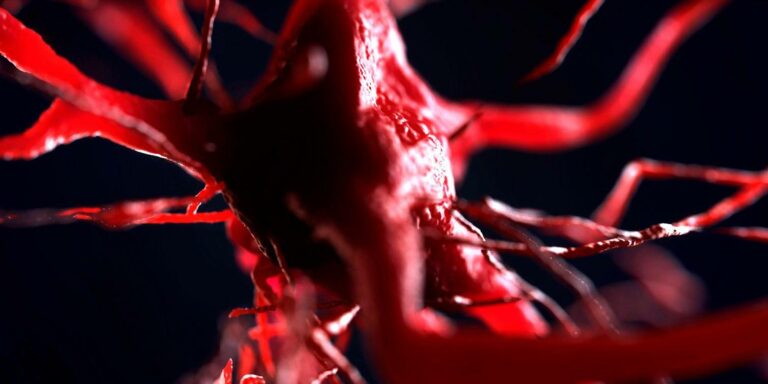

Wyjaśnialność jako cecha własnościowa. Przeszkadza tutaj “czarnoskrzynkowy” charakter uczenia maszynowego, a to właśnie uczenie maszynowe jest najbardziej obiecującym zastosowaniem AI. Rzecz w tym, że algorytmy ML ukrywają przed nami wewnętrzne działanie. Nie da się precyzyjnie określić, gdzie i kiedy została podjęta decyzja. Jeśli nie wiemy, jak działa algorytm AI, jak możemy ufać jego wynikom? Stąd rozwój interpretowalnej lub wytłumaczalnej AI.

Trzeba zajrzeć w głąb black box

Jednym z głównych powodów, dla których AI nie budzi zaufania, jest “czarnoskrzynkowy” charakter uczenia maszynowego. Uczenie maszynowe uchodzi obecnie za najbardziej obiecujące zastosowanie AI. Rzecz w tym, że zastosowane algorytmy ukrywają jego wewnętrzne działanie. Nie da się precyzyjnie określić, gdzie i kiedy została podjęta dana decyzja. To jak maszynka do mięsa, do której wkładamy dorodną kulę z wieprzowiny, a z drugiej wychodzi baranina. Co jest grane? Czy jesteśmy w taniej restauracji w zaułku? Nie, to algorytm AI. A skoro nie wiemy jak do czegoś doszedł, to znaczy jak doszedł do swoich wyników, to jak możemy tym wynikom ufać? Stąd zainteresowanie budzi interpretowalna lub wytłumaczalna AI.

Czarna skrzynka. Machine learning tworzy mikroskopy, a algorytmy black box ryzyko kryzysu replikacji

Czy algorytm sztucznej inteligencji może przeprowadzać samodzielne próby naukowe? Obecnie pytanie brzmi raczej: czy powinien to robić?

Kierunek badań nad SI stara się znaleźć sposób otwarcia czarnej skrzynki. Metody próbują zrekonstruować sposób działania SI w konkretnych zastosowaniach i sytuacjach, a na podstawie tej wiedzy możemy ocenić, czy SI robi to, czego się od niej oczekuje, czy też skręciła w złą stronę. No właśnie – na którym etapie procesu decyzyjnego skręciła w złą stronę? Kiedy chcemy opierać decyzje na inteligencji maszyn, musimy mieć pewność, że działają one w sposób uczciwy, przejrzysty, przewidywalny – nazwijmy to jak chcemy, byle był zrozumiały. Mamy tendencję do strachu przed tym, czego nie rozumiemy, więc po raz kolejny nie można mówić o zaufaniu wobec sztucznej inteligencji. Obawy budzi też prywatność użytkowników konsumenckich zastosowań AI związanych z nowym software’em.

Powody nieufności

Perspektywa, że postępy w dziedzinie AI pomogą ludzkości stawić czoła niektórym z jej najpilniejszych wyzwań, jest ekscytująca, ale nadal istnieją uzasadnione obawy. Jak w przypadku każdej nowej i szybko rozwijającej się technologii, stroma krzywa uczenia się oznacza, że będą błędy w obliczeniach. Nieuchronnie pojawią się nieoczekiwane, a nawet szkodliwe skutki. Sztuczna inteligencja nie jest wobec innych nowych technologii wyjątkiem.

Capgemini w artykule-biuletynie Wiarygodna Sztuczna Inteligencja wymienia pięć wyzwań głównych.

- Transparentność SI. To potrzeba kompleksowych i kontekstowych informacji o tym, jak działają systemy SI, aby wszyscy byli świadomi podejmowanych decyzji i mogli wykrywać błędy.

- Wytłumaczalność SI. Także coraz częściej wymagana przez organy regulacyjne.

- Niezawodność SI: Systemy SI posiadają już pewną autonomiczną zdolność decyzyjną w sytuacjach wysokiego ryzyka. Muszą być na to ryzyko, nieprzewidywalność i zmienność możliwie odporne.

- Sprawiedliwość SI. Systemy uczące się od ludzi odzwierciedlają postawy i uprzedzenia. Zniekształcenia mogą być później powielane, co widać zwłaszcza przez pryzmat niepożądanych społecznie zachowań.

- Prywatność SI. A raczej ochrona prywatności. Mowa o zgodzie z przepisami regulującymi zbieranie, wykorzystywanie i przechowywanie danych.

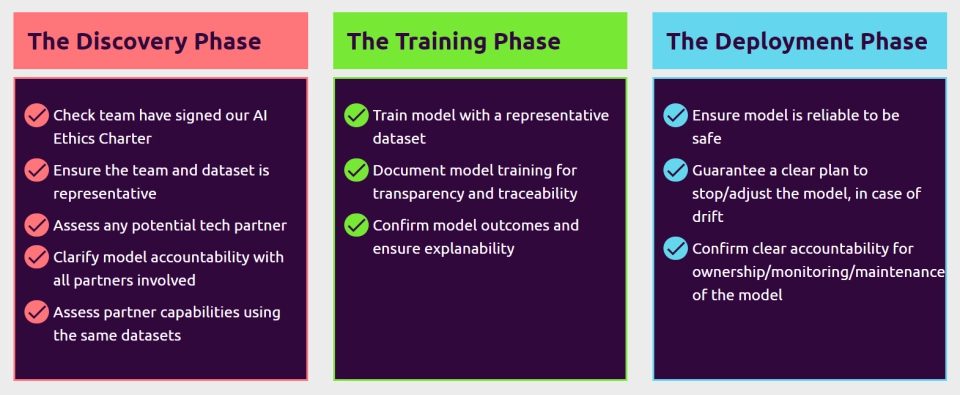

Aby odpowiedzialnie zarządzać projektami i ukierunkować rozwój systemów AI, trzeba będzie nadać priorytet rozważaniom na temat etyki i bezpieczeństwa AI na każdym etapie realizacji projektu AI. Wyprowadzając dyskusję ze sfery teorii do praktyki powstają frameworki AI, jak na przykład Capgemini Trusted AI Framerwork, który w swoich założeniach wyszczególnia kolejne kroki etycznego cyklu życia AI stosowanej.

Nie można ominąć faktu, że istnieje po prostu luka w umiejętnościach. Boryka się z nią wiele firm, organizacji i instytucji. W badaniu IBM z 2018 roku 63% respondentów wymieniło brak umiejętności technicznych jako barierę dla wdrożenia AI. Wiele podmiotów albo nie ma dedykowanego zespołu data science, albo ma bardzo mały zespół, który jest nadmiernie obciążony. Według sieci doradczej Deloitte, w oparciu o obecną podaż i popyt, do 2024 roku w Stanach Zjednoczonych wystąpi niedobór nawet ćwierci miliona naukowców zajmujących się danymi.

AI w biznesie

Kadra kierownicza firm na całym świecie coraz częściej spogląda w stronę sztucznej inteligencji, aby stworzyć nowe pola dla biznesu. Jest to szczególnie widoczne w przypadku czołowych firm, które zainwestowały już w w inicjatywy związane z AI i odnotowały imponujące wyniki. Ta niewielka grupa zdaje się zwiększać owe inwestycje, buduje kompetencje i pracuje nad zwiększeniem skali AI w szerokim ogóle. Możliwości i wyzwania, które stoją przed pionierami są głównym tematem raportów wykonywanych przez MIT Sloan Management Review.

Istnieją firmy, które dokonały skoku w kierunku zaadoptowania AI na dużą skalę – to 18% organizacji sklasyfikowanych w raporcie z 2018 roku jako “pionierzy”. Są to firmy z głębokim zapleczem zespołów data science, które dysponują zasobami umożliwiającymi im tworzenie własnych rozwiązań dla barier niewytłumaczalności. Z pomocą AI firmy te mają szansę zdominować rynek. Zdrowa konkurencja jako zabezpieczenia interesów klientów i pracowników jest zawsze pożądana, dlatego już wkrótce firmy mogą być zmuszone do nadążenia za zmieniającą się falą. Mniejsze lub wciąż jeszcze niezbyt innowacyjne firmy powinny móc korzystać z tych samych narzędzi, z których korzysta już garstka wielkich korporacji.

Postawy wobec sztucznej inteligencji

W badaniu wzięło udział 3 076 uczestników – dyrektorzy, menedżerowie i analitycy z przedsiębiorstw i organizacji z całego świata. Badanie uchwyciło spostrzeżenia osób pracujących w organizacjach różnej wielkości operujących w 29 branżach i zlokalizowanych w 126 krajach. Ponad dwie trzecie respondentów miało siedzibę poza Stanami Zjednoczonymi. Próba pochodziła z różnych źródeł, w tym od czytelników MIT Sloan Management Review i innych zainteresowanych stron. AI była tutaj rozumiana zgodnie z Oxford Dictionary jako “teoria i rozwój systemów komputerowych zdolnych do wykonywania zadań zwyczajowo wymagających ludzkiej inteligencji, takich jak percepcja wzrokowa, rozpoznawanie mowy, podejmowanie decyzji i tłumaczenie”. Respondenci zostali podzieleni na cztery grupy według kryteriów świadomości o AI i wspominamy o tym, bo ten podział dość dobrze odzwierciedla nasze obawy lub nadzieje.

- Wspomniani pionierzy (Pioneers, 18%): Organizacje, które rozumieją i zaadoptowały AI. Te organizacje są na czele, jeśli chodzi o wprowadzanie AI zarówno do swojej oferty, jak i do procesów wewnętrznych.

- Badacze (Investigators, 33%): Organizacje, które rozumieją AI, ale nie wdrażają jej poza fazę pilotażową. Ich badania głównie kładą nacisk na sprawdzenie, co AI może zaoferować.

- Eksperymentatorzy (Experimenters, 16%): Organizacje, które pilotują lub przyjmują AI bez dogłębnego zrozumienia. Te organizacje uczą się poprzez działanie.

- – Pasywni (Passives, 34%): Organizacje, które nie przyjmują i/lub nie rozumieją AI.

Z raportu Artificial Intelligence in Business Gets Real płynie kilka dużych wniosków:

- Ujęci w nim “pionierzy” wciąż pogłębiają swoje przywiązanie i inwestycje w SI. Implikacja jest jasna: nie wycofali się w trakcie. Są chętni do wdrażania AI w całym przedsiębiorstwie, na każdym jego szczeblu.

- Pionierzy, którzy odnieśli wczesny sukces z AI, posiadali w swej kadrze menedżerów znających się na AI, którzy zauważyli problem możliwy do rozwiązania w skuteczniejszy sposób za pomocą AI, na przykład poprzez przetwarzanie języka naturalnego (NLP).

- Pionierzy przedkładali zastosowania AI generujące przychody ponad te, które pozwalają oszczędzać koszty.

- Sztuczna inteligencja budzi wśród pracowników różnego szczebla zarówno strach, jak i nadzieję.

- Tylko 38% ankietowanych CEO spodziewa się redukcji zatrudnienia w związku z AI.

Uczucia głębokie jak uczenie

Emocje związane z AI sięgają głęboko. Nie dotyczą też przecież tylko świata biznesu. Researcher Google Vyacheslav Polonski opisał na łamach czasopisma Scientific American przeprowadzony eksperyment, w którym poprosił osoby z różnych środowisk o obejrzenie różnych filmów science-fiction o AI, a następnie zadał im pytania dotyczące automatyzacji w życiu codziennym. Okazało się, że niezależnie od tego, czy oglądany film przedstawiał AI w pozytywnym, czy negatywnym świetle, samo oglądanie filmowej wizji technologicznej przyszłości polaryzowało postawy. Optymiści stali się bardziej rozentuzjazmowani w postrzeganiu AI, a sceptycy stali się jeszcze ostrożniejsi.

Według autora sugeruje to, że ludzie wykorzystują istotne dowody dotyczące AI w sposób tendencyjny, aby poprzeć swoje dotychczasowe nastawienie. To głęboko zakorzeniona, opisywana przez kognitywistów i filozofów umysłu ludzka tendencja znana jako efekt potwierdzania – z ang. confirmation bias, albo poznawczy błąd konfirmacji. W miarę jak AI jest coraz częściej przedstawiana w mediach, przyczynia się to do głębokiego podziału społeczeństwa na tych, którzy korzystają albo chcą skorzystać z AI i tych, którzy ją odrzucają. Co ważniejsze odmowa zaakceptowania zalet oferowanych przez AI może postawić dużą grupę ludzi w bardzo niekorzystnej sytuacji. Podziały przybiorą wówczas na sile.

Jak pokonać kryzys zaufania wobec SI?

Zbudowanie środowiska do realizacji takich projektów, które umożliwią etyczne projektowanie i wdrażanie systemów AI

wymaga wysiłku multidyscyplinarnych zespołów. Powierzenie tego trudnego i odpowiedzialnego zadania tylko programistom nie wydaje się być dobrym pomysłem. Wymaga to aktywnej współpracy, głęboko zakorzenionej kultury odpowiedzialności i umiejętnej realizacji architektury zarządzania, która przyjmie etyczne praktyki na każdym etapie cyklu życia AI.

Teoretycy i praktycy zaproponowali już kilka pomysłów na to, jak zwiększyć zaufanie społeczne do AI. Samo doświadczenie z AI – doświadczenie praktyczne – może znacząco poprawić nastawienie ludzi do tej technologii. Podobne spostrzeżenia dotyczą również tego, że im częściej korzystamy z innych technologii, takich jak Internet, tym bardziej im ufamy. Zastosowania konsumenckie, które po prostu ułatwiają życie, na przykład analizy ryzyka finansowanego oparte na działaniu algorytmów AI, wydają się być dobrym kierunkiem. W końcu w naturze człowieka leży pytanie: a co ja będę z tego miał?

Innym rozwiązaniem może być otwarcie “czarnej skrzynki” algorytmów uczenia maszynowego i większa przejrzystość co do sposobu ich działania. Firmy takie jak Google, Airbnb i Twitter już teraz publikują raporty przejrzystości dotyczące wniosków rządowych i ujawniania inwigilacji. Podobna praktyka w przypadku systemów AI mogłaby pomóc ludziom lepiej zrozumieć, w jaki sposób podejmowane są decyzje algorytmiczne i odczarować je w powszechnym spojrzeniu.

Większe zaangażowanie ludzi w proces podejmowania decyzji przez SI mogłoby również zwiększyć zaufanie i umożliwić SI uczenie się na podstawie ludzkich doświadczeń. Ludzie, którym dano swobodę nieznacznego modyfikowania algorytmu, byli bardziej zadowoleni z jego decyzji, częściej wierzyli w jego skuteczność i chętniej korzystali lub deklarowali korzystanie z niego w przyszłości.

Nie musimy rozumieć skomplikowanego działania systemów AI, ale jeśli ludzie otrzymają choć trochę informacji na temat sposobu ich wdrażania i będą mieli nad nimi kontrolę, będą bardziej otwarci na przyjęcie AI do swojego życia.

Jak oceniasz ten wpis blogowy?

Kliknij gwiazdkę, aby go ocenić!

Średnia ocena: 4.7 / 5. Liczba głosów: 3

Jak dotąd brak głosów! Bądź pierwszą osobą, która oceni ten wpis.