Spis treści:

W obecnych czasach jednym z pierwszych skojarzeń związanych z elektroniką jest oczywiście przemysł komputerowy. Otoczeni jesteśmy cyfrowymi urządzeniami, dzięki którym pracujemy uzupełniając kolejne tabelki w Excelu, wypoczywamy oglądając na ekranie telewizora kolejny sezon ulubionego serialu, czy też zamawiamy jedzenie poprzez jedną z aplikacji dostępnych na smartfonie. Nowoczesne urządzenia skojarzone wokół szeroko pojętego przemysłu komputerowego to niesamowite narzędzia, które jak nigdy wcześniej pozwalają na dostęp do informacji zgromadzonych w największej encyklopedii, jaką stworzył człowiek, czyli internetu. Tylko od nas zależy, po co tak naprawdę sięgniemy. Jednak nie zawsze tak było, nie tak dawno, bo jeszcze w pierwszej połowie XX wieku świat zdominowany był przez technikę analogową.

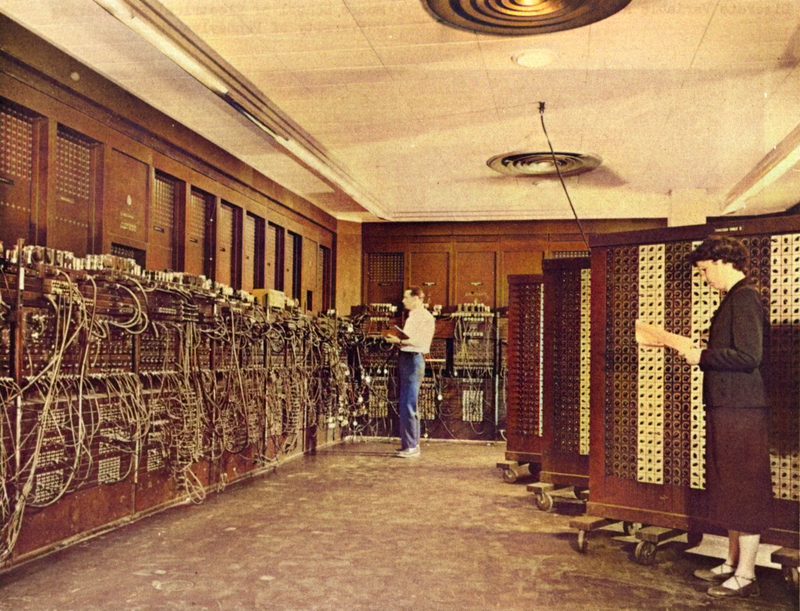

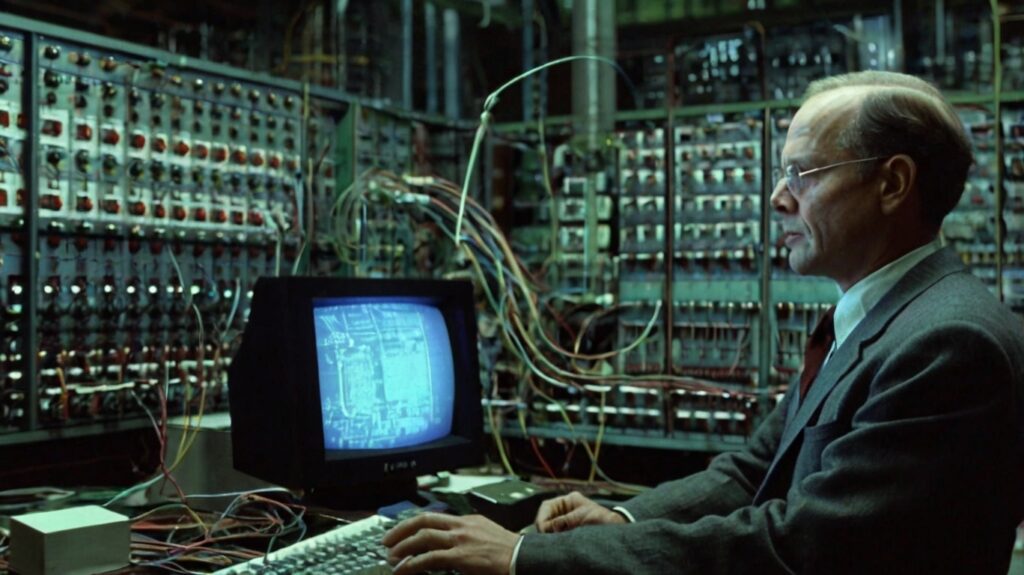

W tamtych czasach urządzenia bazowały na parametrach sygnału elektrycznego. Mogła być to wartość napięcia, płynącego prądu, czy częstotliwość, ale powszechne dzisiaj wartości logicznego zera i jedynki (bazujące nomen omen na napięciu elektrycznym), znane już teoretycznie nie były tak szeroko wykorzystywane. Popularne sprzęty, takie jak radioodbiorniki, pierwszy telewizor, czy wczesne maszyny liczące, które moglibyśmy nazwać dziś prostymi komputerami, bazowały na lampach elektronowych. Komponenty te, mimo że już nieco zapomniane były podstawowym elementem składowym obwodów elektronicznych. Pełniły one funkcję elementów wzmacniających i przełączających i mimo że zrewolucjonizowały rynek, obarczone były też wieloma wadami. Lampy były duże, energochłonne i podatne na awarie, co sprawiało, że budowa bardziej złożonych systemów, takich jak wspomniane wyżej pierwsze komputery była niezwykle trudna. Przykładem tego typu urządzenia mogą być ENIAC, Colossus czy UNIVAC, które stanowią kamienie milowe technologii komputerowej. Konstrukcje te w latach swojej świetności mogły imponować, dla przykładu ENIAC mógł wykonywać około 5000 operacji dodawania lub odejmowania w ciągu sekundy. Jednak mimo to komputer ważył 27 ton, pobierał 140kW mocy, zajmował około 140 metrów kwadratowych i ulegał awarii średnio co dwa dni.

Technologia lamp próżniowych, mimo że w swoim czasie potężna i rewolucyjna nie potrafiła sprostać wymaganiom ciągle zmieniającego się świata technologii. Ówczesnym inżynierom i projektantom potrzebne było coś „lepszego”, coś, co będzie wstanie zastąpić lampy i jednocześnie wyeliminuje wszystkie ich wady.

Alea iacta est – powstanie tranzystora

Na alternatywę dla dużych i nieporęcznych lamp elektronowych nie musieliśmy długo czekać. W 1947 roku John Bardeen, William Shockley i Walter Brattain pracujący w laboratoriach Bell Labs, które było miejscem wielu innowacyjnych odkryć, opracowali pierwszy prototyp tranzystora. Choć pierwsze koncepcje elementu półprzewodnikowego tego typu pochodzą już z lat 20 XX wieku, to dopiero tranzystor, który dziś określilibyśmy jako tranzystor punktowy, był rzeczywiście funkcjonującym elementem.

Składał się on z germanowej płytki, do której przymocowano złotą folię, która następnie przecięto na dwie części. W ten sposób uzyskano funkcjonalną półprzewodnikową kanapkę złoto-german-złoto. Pierwsze tranzystory, mimo że niedoskonałe zostały niemal natychmiast zauważone jako ciekawa alternatywa dla lamp próżniowych. Kolejne iteracje tranzystora, a przede wszystkim krzemowa konstrukcja z 1951 roku eliminująca temperaturowe problemy germanowych elementów, które ulegały uszkodzeniu po przekroczeniu mniej więcej 75°C, były jeszcze bardziej doskonałe. Nowe elementy mogły wzmacniać sygnały, ale najważniejszym aspektem były stan nasycenia lub zatkania, w który mógł być wprowadzony tranzystor.

Stan nasycenia można w prosty sposób określić jako sytuację, w której przez tranzystor przepływa prąd i analogicznie w stanie zatkania, prąd nie płynie. Jest to oczywiście pewne uproszczenie, ale przy odpowiednim wysterowaniu komponent ten mógł zachowywać się jak przełącznik, włączając lub wyłączając przepływ prądu. Korelacja przepływającego prądu i wartości napięcia, która odkłada się na danym elemencie była już powszechnie znana i bardzo szybko zauważono, że tranzystor może działać jako fizyczny element reprezentujący logiczne stany logiki Boolea, odzwierciedlając logiczną jedynkę lub zero.

Tranzystor pełniący rolę przełącznika nadawał się wręcz idealnie do przetwarzania sygnałów cyfrowych, w których to informacje kodowane były za pomocą stanów logicznych, a te w rzeczywistości reprezentowane były przez odpowiednie wartości napięcia elektrycznego.

Zapomniane hybrydy

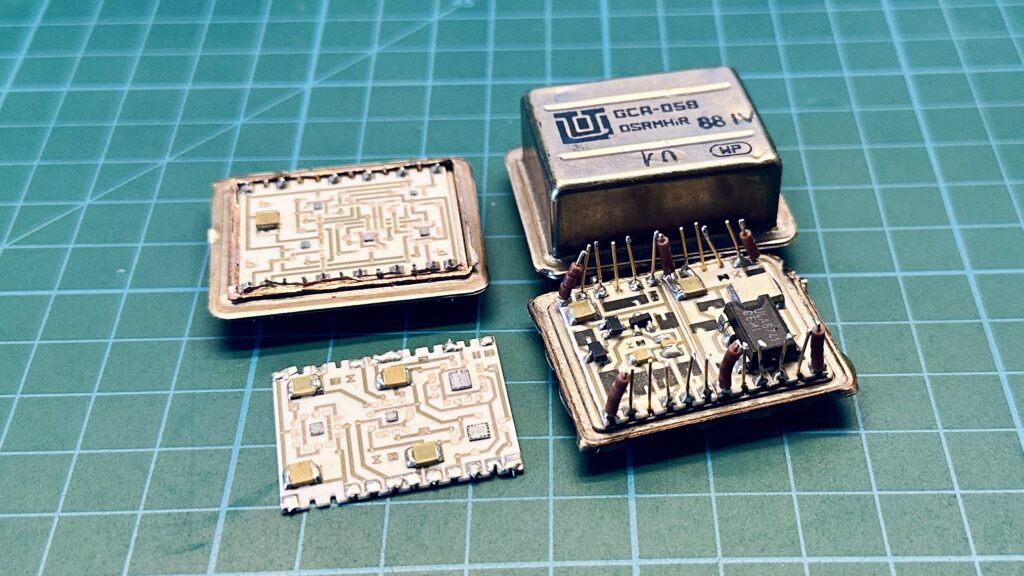

Hybrydowe elementy elektroniczne kojarzyć możemy przede wszystkim z popularnych pod koniec XX konstrukcji. Łączyły one znane już we wcześniej elementy przewlekane z ówczesną nowością, czyli montażem powierzchniowym. Przykładem tego typu konstrukcji mogą być układy GCA-058 i GCA-056 wyprodukowane w Krakowskim Ośrodku Badawczo Rozwojowym Unitry. Jak widać, łączą one klasyczny chip w obudowie DIP8, kondensatory SMD, krzemowe rdzenie montowane bezpośrednio na ceramicznym podłożu oraz napylane na nim rezystory. Choć elektronika hybrydowa kojarzy się właśnie z takimi produktami, już znacznie wcześniej powstawały konstrukcje, które możemy określić tym mianem.

Pierwsze tranzystory były w swoim czasie rewolucyjne, ale wielu producentów podchodziło do nich z pewnym dystansem. Drogie, nieznane i potencjalnie problematyczne elementy, mogły w rzeczywistości generować nikomu niepotrzebne problemy. Dlatego we wczesnych urządzeniach stosowano tranzystory równolegle z dobrze znanymi i dopracowanymi lampami próżniowymi.

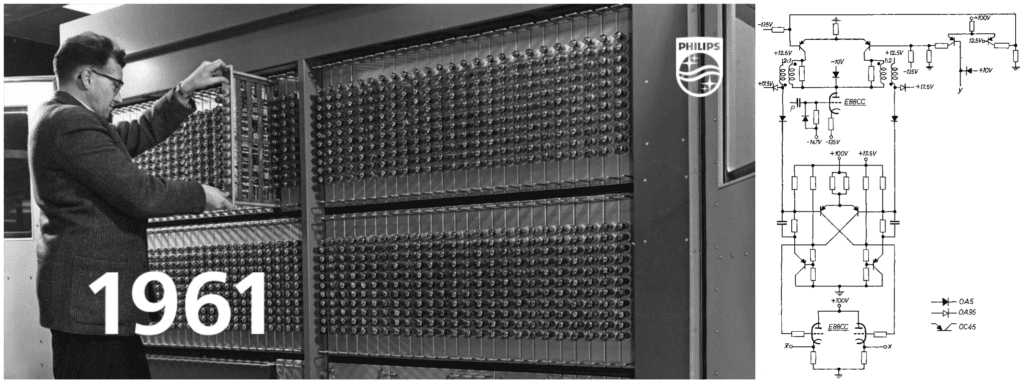

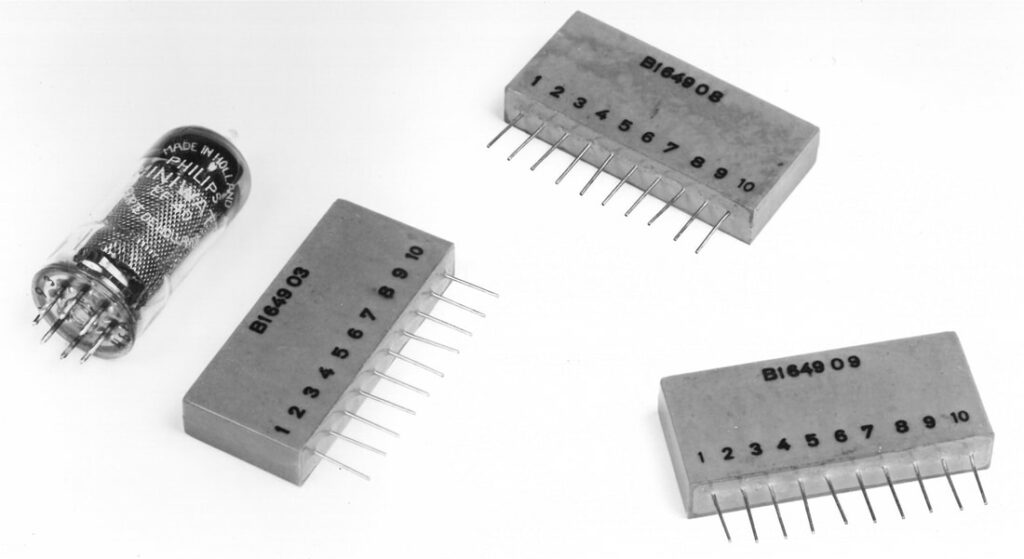

Na takie rozwiązanie zdecydował się między innymi Holenderski Philips. W zaprojektowanym przez tego producenta systemie komputerowym PASCAL i bliźniaczym STAVIN korzystano z hybrydowych modułów opartych na kombinacji lamp elektronowych E88CC, tranzystorów OC45 (PNP) i rezystorów. W sumie komputer wyposażony był w 1100 takich obwodów, zamontowanych w systemie modułowym. Jest to jednak tylko mały wycinek z systemu PASCAL/STAVIN, w sumie komputer zbudowany był z 2000 lamp, 10 000 tranzystorów i 15 000 diod.

Choć Philips może jawić się nam jako w gruncie rzeczy zamknięta na nowości firma, budująca hybrydowe obwody, które nadal w dużej mierze bazowały na szklanych bańkach, trzeba wspomnieć, że obraz taki może być mylący. Od momentu, gdy pracownicy Bell Labs pokazali światu tranzystor, kierownictwo Philipsa zdawało sobie sprawę z możliwości jakie w przyszłości mogą oferować te elementy. Efektem chłodnej kalkulacji, był pogląd, że w przemysł półprzewodnikowy należy inwestować, bo przyszłość przyniesie najpewniej schyłek lamp próżniowych i erę tranzystorów.

Pewną ciekawostką są też działania Philipsa na stosunkowo niewielkim i nieprzynoszącym dużych zysków hobbystycznym rynku elektroniki tamtych lat. Już na przełomie 1957 i 1958 roku firma zdecydowała się promować broszurę „Pionier I”, w której opisano samodzielną budowę radioodbiornika, bazującego na tranzystorach OC13 i OC14. Ironią losu jest fakt, że elementy te były zasadniczo odpadkiem z procesu produkcji tranzystorów oznaczanych jako OC71 i OC72. Dostępne źródła sugerują, że wypaczone konstrukcje charakteryzowały się tylko mniejszym parametrem wzmocnienia, ale zapewne miało to też wpływ na ogólne działanie zbudowanego radioodbiornika.

Logika tranzystorowo-rezystorowa i pochodne

Niedaleko pada tranzystor od układu scalonego. Pojawienie się pierwszych półprzewodnikowych elementów otworzyło drogę projektantom i inżynierom do budowy konstrukcji, które dzisiaj nazwalibyśmy układami scalonymi. Te zaczęły się pojawiać niemal równolegle z coraz to nowszymi prototypami kolejnych tranzystorów. Początkowo „układy scalone” były tak naprawdę zamkniętymi w hermetycznej obudowie tranzystorami warz z towarzyszącymi im elementami biernymi. Można by polemizować, czy tego typu sprzęty możemy nazywać układami scalonymi. W gruncie rzeczy, były to hybrydy, podobnie jak tranzystorowo-lampowe obwody komputera PASCAL. Z tą różnicą, że konstrukcje te były znacznie mniejsze i co ważne po zamknięciu i zalaniu korpusu żywicą epoksydową, dostanie się do wnętrza było już niemożliwe, co przypomina dzisiejsze układy scalone.

Jednak niezależnie czy pierwsze puszki z umieszczonymi wewnątrz półprzewodnikami nazwiemy układami scalonymi, czy też hybrydami już wówczas można zauważyć trend miniaturyzacji, która miała dopiero nadejść.

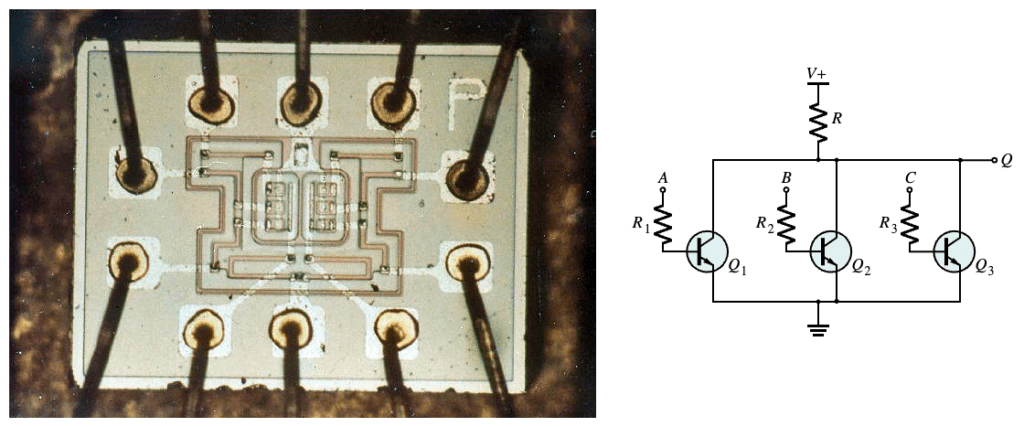

Krokiem milowym możemy uznać pojawienie się pierwszych chipów wykonanych w technologii RTL (Resistor-Transistor Logic). Choć początkowo konstrukcje tego typu opierano na elementach dyskretnych, to postępujący rozwój branży półprzewodnikowej pozwolił z czasem budować obwody bazujące na pojedynczej krzemowej płytce. Obróbka krzemu pozwoliła umieszczać elementy takie jak tranzystory i rezystory na wspólnym podłożu, co z dzisiejszego punktu widzenia jest naprawdę przełomowe. Wspólne podłoże pozwoliło wówczas rozpocząć wielkoskalową produkcję obwodów złożonych z kilku elementów, które byłby bardzo małe.

Pierwszymi układami RTL były pojedyncze lub podwójne bramki logiczne. Jednym z przedstawicieli tego nurtu jest podwójna wielotranzystorowa bramka NOR, którą możecie zobaczyć na fotografii powyżej. Co ciekawe element ten był jednym z komponentów wchodzących w skład Apollo Guidance Computer, czyli komputera pokładowego statków Apollo.

Technologia RTL, mimo że przełomowa borykała się z szeregiem problemów. Chipy tego typu były dość prądożerne a poza tym wrażliwe na zakłócenia. Dlatego w kolejnych latach powstała koncepcja budowania układów na bazie tranzystorów i diod (DTL), która ostatecznie wyewoluowała w dość powszechnie znaną technologię TTL (Transistor-Transistor Logic).

Cyfrowe szaleństwo

Lata 70 XX wieku to czas, w którym cyfrowy wariant elektroniki zbudował fundamenty przyszłej dominacji. Stopniowy rozwój przemysłu półprzewodnikowego pozwolił budować coraz to bardziej złożone układy scalone, mogące realizować naprawdę niezwykłe funkcje, ale powstanie pierwszego mikroprocesora okazało się kolejnym krokiem milowym. W 1971 roku zerwano z dotychczasową zasadą projektowania elektroniki specjalizowanej. W tamtym czasie Ted Hoff i Federico Faggin zaprezentowali światu pierwszy chip mogący realizować zapisany w pamięci program – Intel 4004. W ten sposób świat elektroniki wzbogacił się o konstrukcję uniwersalną, dzięki której możliwe było zrealizowanie dowolnego, wymyślonego przez programistę zadania.

Niespełna dwa lata później, pojawił się kolejny, znacznie bardziej zaawansowany i wydajny mikroprocesor – Intel 8080. Rewolucji nie można było już zatrzymać, w kolejnych latach rynek procesorów zaczął coraz bardziej rosnąć, a konkurencja między firmami, takimi jak Intel i AMD, przyczyniła się do stałego wzrostu mocy obliczeniowej. Procesory rosły zgodnie z prawem Moore’a, pojawiło się coraz więcej rdzeni, rosło taktowanie, a wszystko to pozwalało tworzyć coraz bardziej złożone oprogramowanie.

Cyfrowa rewolucja zapoczątkowana przez rozwój mikroprocesorów zmieniła niemal wszystkie aspekty naszego życia. Zaczynając od przemysłu, gdzie komputery sterowane mikroprocesorami zautomatyzowały produkcję i zarządzanie, przez sektor telekomunikacyjny, gdzie cyfrowa transmisja danych zrewolucjonizowała sposób, w jaki komunikujemy się na odległość, aż po naszą codzienność można bez wątpienia powiedzieć – mikroprocesory są wszędzie. To one napędzają nasze smartfony, samochody, a nawet domowe urządzenia AGD i RTV.

Cyfrowa konieczność?

Rozwój cyfrowej elektroniki wydaje się czymś naturalnym, jednak czy zastanawialiście się kiedyś, jak wyglądałby świat, gdyby systemy nadal bazował na sygnałach analogowych tak jak w początkowych latach? Spróbujmy sobie wyobrazić, że tranzystor nigdy nie powstaje, a komputery są ogromnymi maszynami zajmującymi całe budynki. Innym aspektem jest też system, na jakim mogłyby bazować takie urządzenia. Czy konstrukcje lampowe mógłby przetwarzać informacje w systemie innym niż znany dziś binarny? Co ciekawe istniały komputery operujące na systemie dziesiętnym i jednym z ich przedstawicieli może być wspominany wcześniej ENIAC. Przetwarzanie liczb w ten sposób z ludzkiej perspektywy wydaje się naturalniejszy, a elektronika analogowa pozwalała budować też inne systemy. Ciekawa wydaje się koncepcja maszyn liczących operujących na jeszcze wyższych systemach liczbowych, można by zaryzykować tezę, że byłby one wydajniejsze niż dzisiejsze komputery, bazując na znanej teorii głoszącej, że rozwój człowieka byłby znacznie szybszy, gdybyśmy bazowali na systemie większym niż dziesiętny.

W rozważaniach o alternatywnej rzeczywistości musimy zdać też sobie sprawę z ewentualnych problemów. Świat bez cyfrowej technologii byłby prawdopodobnie znacznie mniej zglobalizowany i nawet jeśli dysponowalibyśmy większą mocą obliczeniową, to nie byłaby ona tak powszechna jak dziś.

Zastanowić możemy się też nad konceptami, które mógłby się rozwinąć, gdyby nie elektronika cyfrowa. Jednym z nich są układy optyczne, oparte na świetle, które nawet teraz są ciekawą alternatywą dla klasycznej elektroniki, zainteresowanych tym tematem zachęcam do poszukania informacji o układach typu „photonic chip”. Jednak zdaje się, że ta gałąź technologii nie potrafi sobie poradzić z problemami miniaturyzacji i kosztami produkcji. Warto także przyjrzeć się koncepcji „analogowych komputerów kwantowych”, które mogłyby znaleźć zastosowanie w określonych dziedzinach przetwarzania danych.

Chociaż układy cyfrowe zdominowały świat technologii, ostatnie lata przyniosły nowe próby wykorzystania konstrukcji analogowych. Procesory analogowe, dzięki swojej zdolności do przetwarzania sygnałów ciągłych, mogą oferować niedostrzegalną dotąd przewagę w niektórych zastosowaniach, zwłaszcza tam, gdzie kluczowe są szybkość. Jednym z najbardziej obiecujących konceptów są analogowe sieci neuronowych, które mogą w przyszłości zrewolucjonizować sztuczną inteligencję i uczenie maszynowe. Tradycyjne procesory cyfrowe, choć potężne, mają swoje ograniczenia w symulowaniu działania ludzkiego mózgu. Analogowe podejście może oferować bardziej efektywne przetwarzanie danych. Pamiętajmy też o możliwość łączenia technologii analogowych i cyfrowych w układy hybrydowe, może to otworzyć całkiem nowe horyzonty optymalizacji przetwarzania informacji.

Co by nie mówić galopujący rozwój sztucznej inteligencji będzie potrzebować mocy, a uproszczając, mocy jest tak wiele, jak wiele oferuje jej najnowszy chip Nvidi i jest to ograniczenie, z którego wielu nie zdaje sobie dzisiaj sprawy. Bazujemy na sygnałach cyfrowych, ale kto wie, co przyniesie przyszłość i czy tak naprawdę nie jesteśmy w przededniu kolejnej elektronicznej rewolucji.

Źródła:

- https://en.wikipedia.org/wiki/ENIAC

- https://penntoday.upenn.edu/news/worlds-first-general-purpose-computer-turns-75

- https://www.maximus-randd.com/digital-circuit-blocks.html

- https://nl.wikipedia.org/wiki/PASCAL_(computer)

- https://en.wikipedia.org/wiki/Resistor–transistor_logic

- https://graemeing.medium.com/the-intel-4004-the-worlds-first-microprocessor-84e25269c797

- https://www.quera.com/glossary/analog-quantum-computing

- https://phys.org/news/2023-01-analog-quantum-previously-unsolvable-problems.html

- https://research.ibm.com/blog/analog-ai-chip-low-power

Jak oceniasz ten wpis blogowy?

Kliknij gwiazdkę, aby go ocenić!

Średnia ocena: 4.8 / 5. Liczba głosów: 9

Jak dotąd brak głosów! Bądź pierwszą osobą, która oceni ten wpis.