Spis treści:

Ostatnimi czasy w mediach głośno było o problemach firmy Intel i choć tego typu newsy nie są niczym nowym. Wszakże co rusz możemy przeczytać o kolejnych potknięciach technologicznych gigantów, to tym razem wydaje się, że Intel rzeczywiście stracił równowagę i niechybnie znalazł się na kursie kolizyjnym z powierzchnią ziemi. Ostatnie problemy z mikrokodem i utleniającym się krzemem przerosły amerykańskiego kolosa. Czego efektem były masowe zwolnienia pracowników, wstrzymanie inwestycji, a nawet plotki o przejęciu przez firmę Qualcomm. Jednak jeden czy dwa kwartały zakończone finansowym minusem nie muszą oznaczać wcale niechybnego upadku. Wręcz przeciwnie może się okazać, że aktualne potknięcia będą impulsem do głębokiej restrukturyzacji i przemodelowania biznesu, a po wszystkim Intel okaże się bardziej dojrzałym przedsiębiorstwem. W tym artykule postaram się pokazać wam sytuację firmy nieco szerzej, zarówno z jej historycznymi problemami, jak i sukcesami.

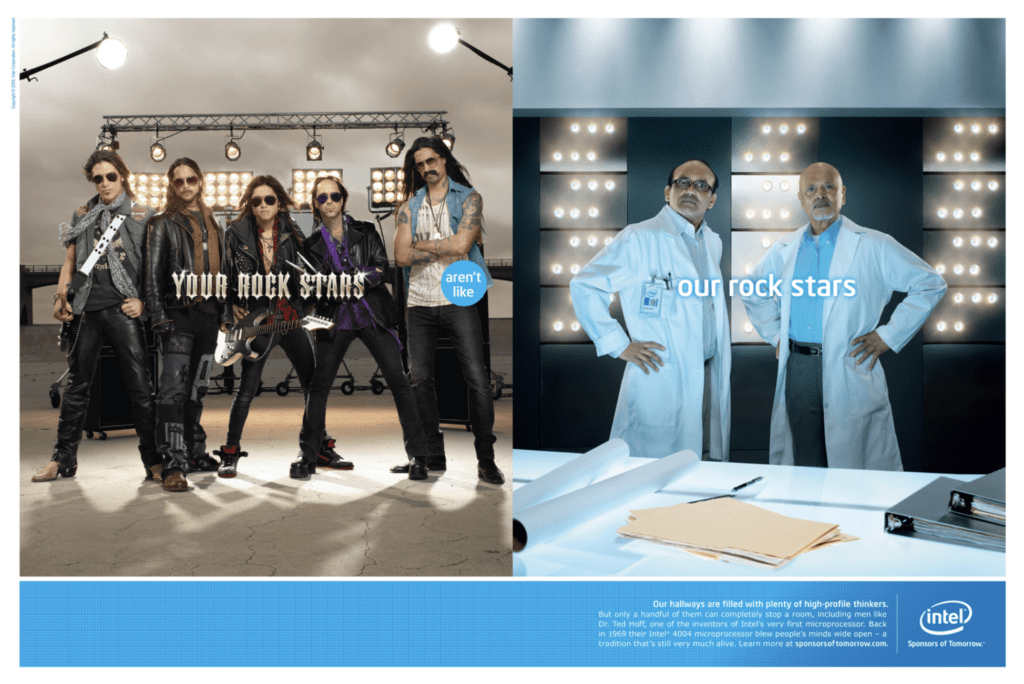

„Sponsors of tomorrow”, tak brzmiało jedno z marketingowych haseł Intela, z którym rzeczywiście trudno się nie zgodzić. W wielu momentach historii amerykańska firma dominowała, wyznaczała trendy, a jej produkty były obiektem pożądania wielu osób składających własny komputer. Wydaje się jednak, że z czasem niebiescy przestali nadążać i gdy wcześniej to właśnie oni kreowali kolejne technologiczne nowości, dzisiaj pozostało im tylko podążanie za konkurencją. Problemy z wprowadzaniem kolejnych litografii, zaprzepaszczony rynek procesorów graficznych, konkurencyjna architektura ARM to tylko kilka z całej listy byłych, obecnych i potencjalnych problemów Intela. Jednak, aby móc w pełni zrozumieć sytuację firmy, musimy zacząć od początku.

Krótka historia „niebieskiego” krzemu

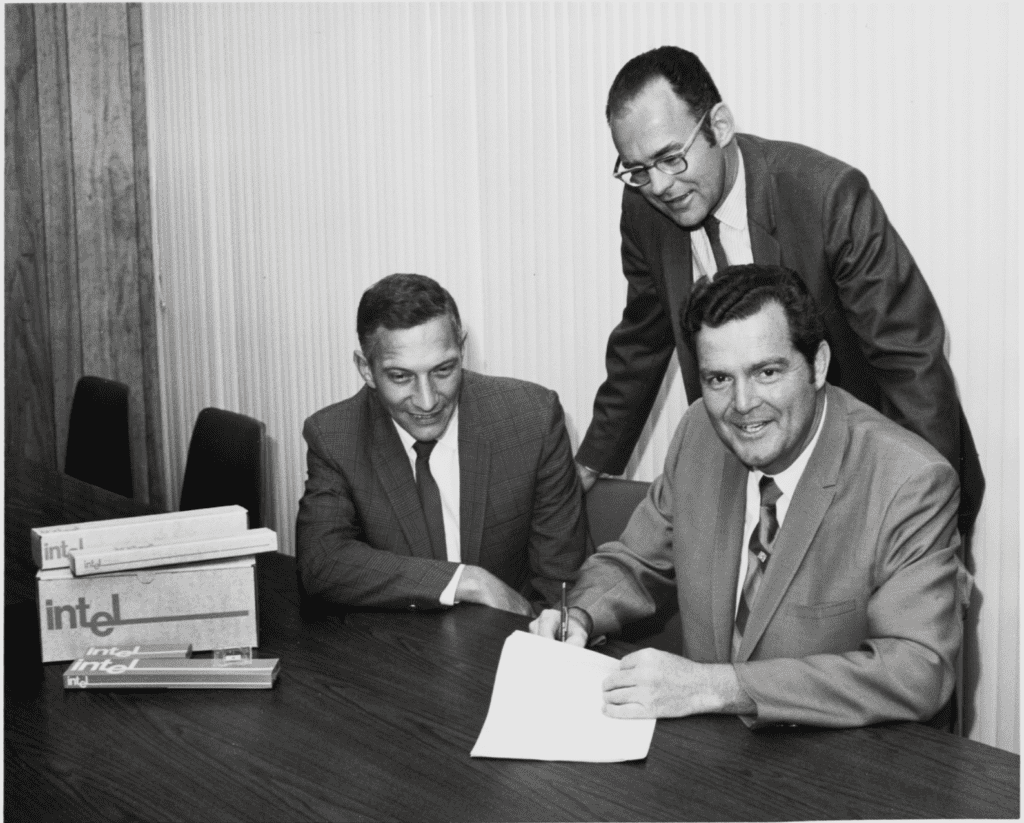

Lata 60. w Stanach Zjednoczonych to czas gwałtownie rozwijającego się przemysłu półprzewodnikowego. W tamtym czasie dwóch pracowników firmy Fairchild Semiconductor, która była ówcześnie jednym z pionierów krzemowych technologii, dochodzi do wniosku, że w ich życiu potrzebna jest jakaś zmiana. Wiedzeni wizją innowacyjności i rozwoju, Robert Noyce będący jednym z współtwórców pierwszego układu scalonego oraz Gordon Moore, który sformułował tak zwane „Prawo Moore’a”, o którym swoją drogą przygotowałem kiedyś artykuł „Prawo Moore’a 50 lat później”, postanawiają założyć własną firmę półprzewodnikową. Co ciekawe nazwa Intel, będąca skrótem od „Integrated Electronics” nie była pierwszym wyborem. Początkowo przedsiębiorstwo miało nosić nazwę „Moore Noyce”, jednak przez fonetyczną zbieżność ze słowami „more noise” (więcej szumu), co w elektronice jest terminem negatywnym, twórcy zdecydowali się ostatecznie na Intel.

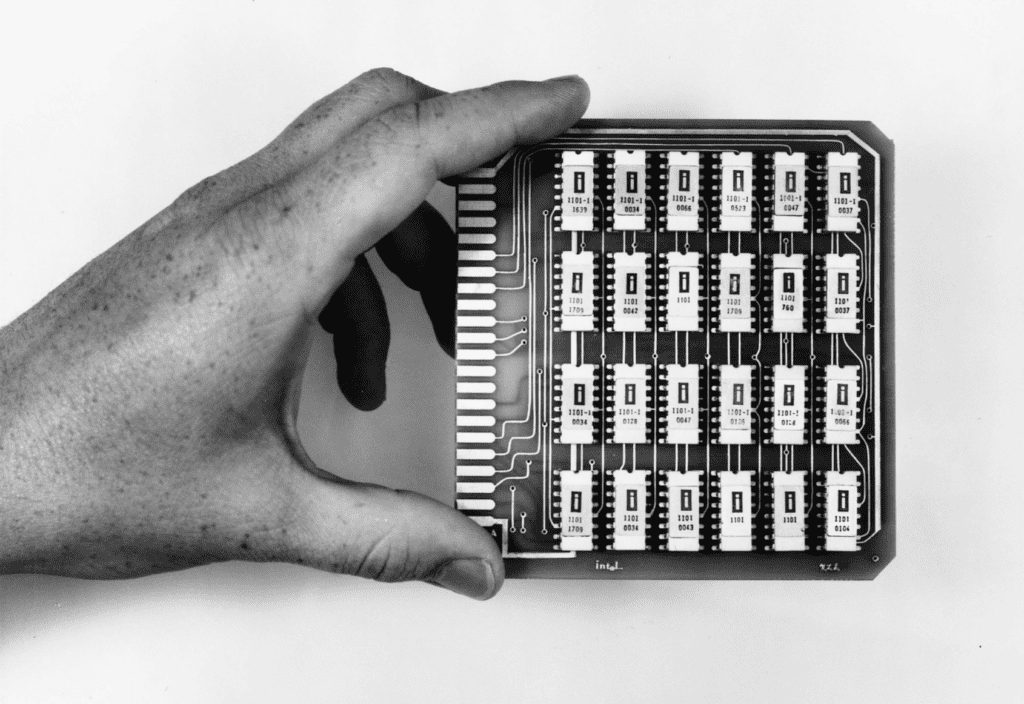

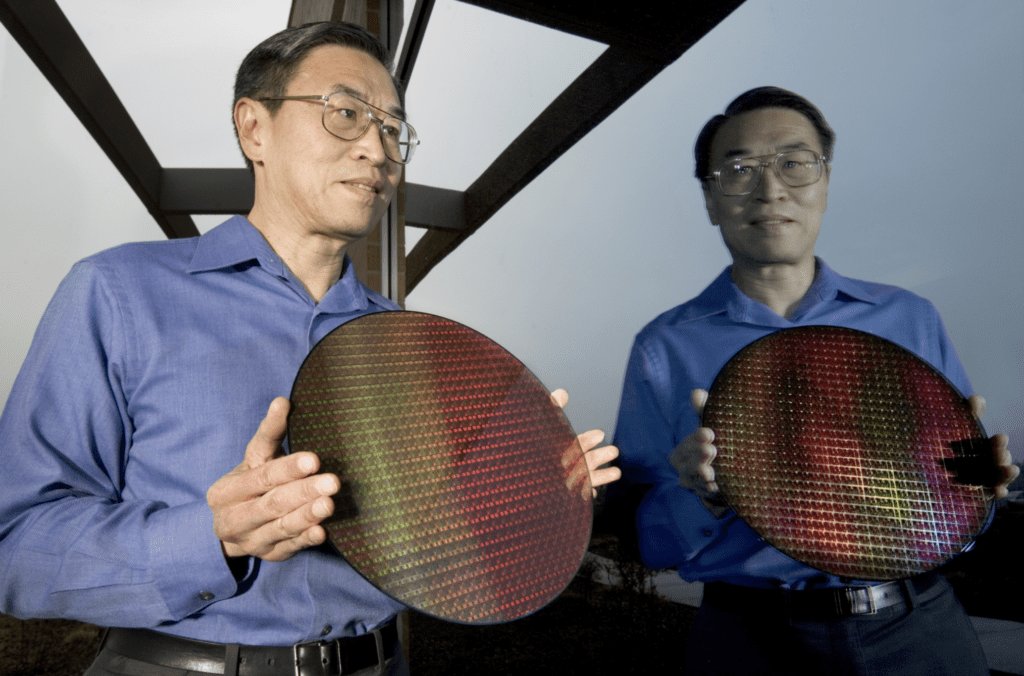

Dwójka uczonych wraz z inwestorem Arthurem Rock’iem zaczyna swoją działalność w 1968 roku. Rok później na rynku pojawia się ich pierwszy komercyjny produkt, chip o oznaczeniu 1101, będący statyczną pamięcią SRAM. Układ okazuje się strzałem w dziesiątkę deklasującym pod względem szybkości i niezawodności stosowane ówcześnie w stacjach roboczych i komputerach magnetyczne pamięci ferrytowe. Sukces 1101 pozwolił zdobyć fundusze niezbędne do dalszego rozwoju Intela. Dzięki nim na rynek wchodzą kolejne iteracje chipów amerykańskiego producenta.

Intel zaczynał od pamięci, jednak prawdziwa rewolucja przychodzi w 1971 roku. To wówczas światło dzienne ujrzał zaprojektowany przez Teda Hoffa i Federico Faggin’iego pierwszy mikroprocesor o oznaczeniu 4004. Chip ten był przełomowy, zrywał on z dotychczasową zasadą projektowania elektroniki specjalizowanej, dostosowanej do konkretnego zadania. Intel 4004 był uniwersalny, jego zadaniem było realizować program, a jaki on będzie to nie miało znaczenia.

4004, mimo że uniwersalny projektowany był tak naprawdę do pracy w jednym z Japońskich kalkulatorów Busicom. Wydaje się, że nawet sami twórcy nie zdawali sobie sprawy z możliwości układu, na które zwrócono uwagę dopiero po jego premierze. Społeczna presja wywołała mikroprocesorową rewolucję, której efektem był Intel 8008. Chip znacznie bardziej zaawansowany, dopracowany i wydajny.

Jedną z technologii, którą zawdzięczamy Intelowi, jest też architektura x86. Termin ten pojawił się wraz z premierą mikroprocesora 8086 w 1978 roku. Przez kolejne dziesięciolecia architektura ta, będąca de facto zbiorem zasad projektowania procesorów zdominowała rynek. Wydajność, jak i kompatybilność wsteczna okazała się bezkonkurencyjna, dzięki czemu termin x86 na stałe zapisał się w historii przemysłu komputerowego.

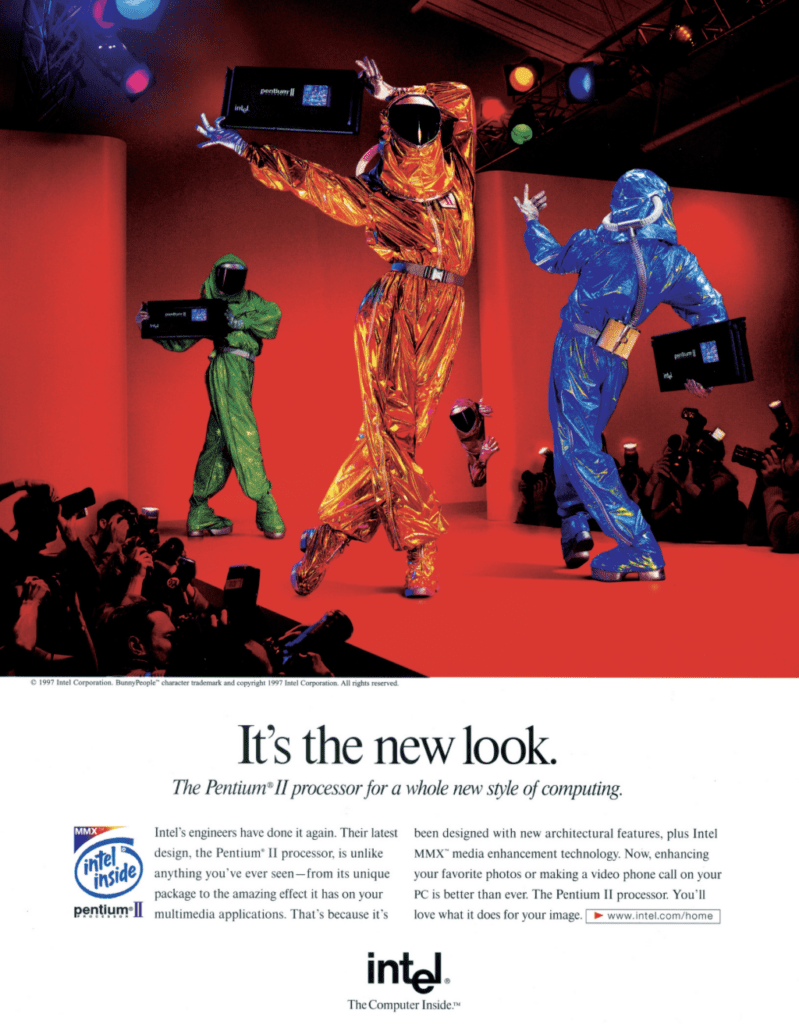

Mówiąc o Intelu, nie możemy zapomnieć też o kultowych seriach procesorów. Jedną z nich jest Pentium, wprowadzony na rynek w 1993 roku. Jednostki te stanowiły spory postęp technologiczny w stosunku do swoich poprzedników z serii 485. To właśnie w tych chipach po raz pierwszy zastosowano 32-bitową architekturę superskalarną. Innymi słowy, układy te wspierały przetwarzanie kilku instrukcji w jednym cyklu zegarowym, co znacznie zwiększyło wydajność. Inną serią jednostek centralnych jest też Centrino, czyli procesory zaprojektowane do pracy w komputerach przenośnych. Ich wyróżnikiem był nie tylko niski pobór mocy, co pozwalało na dłuższą pracę na baterii, ale też stosunkowo dobra wydajność przy niskich częstotliwościach taktowania. Myśląc o wielordzeniowych procesorach, nie można zapomnieć o jednostkach Core wprowadzonych w 2006 roku. Był to kamień milowy przemysłu komputerowego umożliwiający równoległe przetwarzanie zadań. Dzięki temu systemy operacyjne mogły jeszcze lepiej wykorzystywać zasoby procesora, co dla użytkownika oznaczało znaczny wzrost wydajności.

Serie procesorów takie jak Pentium, Centrino i Core przez lata wyryły się w świadomości użytkowników sprzętu komputerowego. Jednak mimo wielu przełomowych technologii Intel zmagał się też z wieloma kryzysami i problemami, które mimo szczerych chęci nie zostały przezwyciężone.

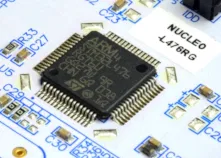

Kłopoty z litografią

Czy układ scalony wykonany w technologii 14nm może być lepszy niż chip 10nm lub nawet 7nm? Przez lata Intel twierdził, że tak, do tego stopnia, że stało się to memem, gdzie do opisów procesorów niebieskich przy informacji o 14nm dostawiano kolejne i kolejne plusy. Mimo że cała sytuacja mogła wydawać się zabawna, to zarządowi Intela raczej nie było do śmiechu.

Przez lata Intel borykał się z problemem litografii. Przejście na technologię 10nm ogłoszone zostało po raz pierwszy już w 2015 roku, ale cały proces ciągnął się przez około 5 lat do 2020 roku. Podobnie zresztą było z układami 7nm, które początkowo były chipami „10nm Enhanced Superfin”, przemianowanymi później na „Intel 7”. Dla zobrazowania jak wielkie były przestoje Intela wystarczy wspomnieć, że Samsung produkował układy 10nm już w 2012 roku, natomiast Tajwańskie przedsiębiorstwo TSMC uznało, że proces 10nm jest zbędny i w 2016 roku uruchomiło linię technologiczną dla chipów 7nm.

Problemy Amerykanów z produkcją procesorów są w gruncie rzeczy dość zastanawiające. Z medialnych doniesień wiemy o stricte technologicznych przeciwnościach, które przez te wszystkie lata pojawiały się w fabrykach produkujących półprzewodniki. Te mogą poniekąd usprawiedliwiać Intela, ale według mnie przyczyną problemów jest coś innego – podejście do projektowania chipów. Przez lata firma trwała tak naprawdę w jednym rozwiązaniu, gdzie wszystkie komponenty procesora mają być upakowane w jednym kawałku krzemu. Ma to swoje zalety, ale produkcyjnie jest trudniejsze do zrealizowania. Dla przykładu procesory AMD Zen zaprojektowane zostały nieco bardziej modułowo i mogą składać się z dwóch osobnych krzemowych rdzeni. Takie rozwiązanie jest prostsze w produkcji, ale przez odległości między poszczególnymi komponentami jednostki centralnej jest ona wolniejsza. Intel dominuje pod względem szybkości działania pojedynczego rdzenia, również dzięki wyższemu i lepiej zoptymalizowanemu taktowaniu, które znacznie łatwiej ujarzmić w pojedynczym rdzeniu. Jednak mimo zalet rozwiązanie to wpędziło Intela w kłopoty. Jak wiemy, pierwsze próby uruchomienia produkcji układów w mniejszych nanometrach kończyły się porażką, a taki sam chip wykonany w starszym procesie technologicznym okazywał się nie raz bardziej wydajny, mimo że na papierze sytuacja wyglądała odwrotnie.

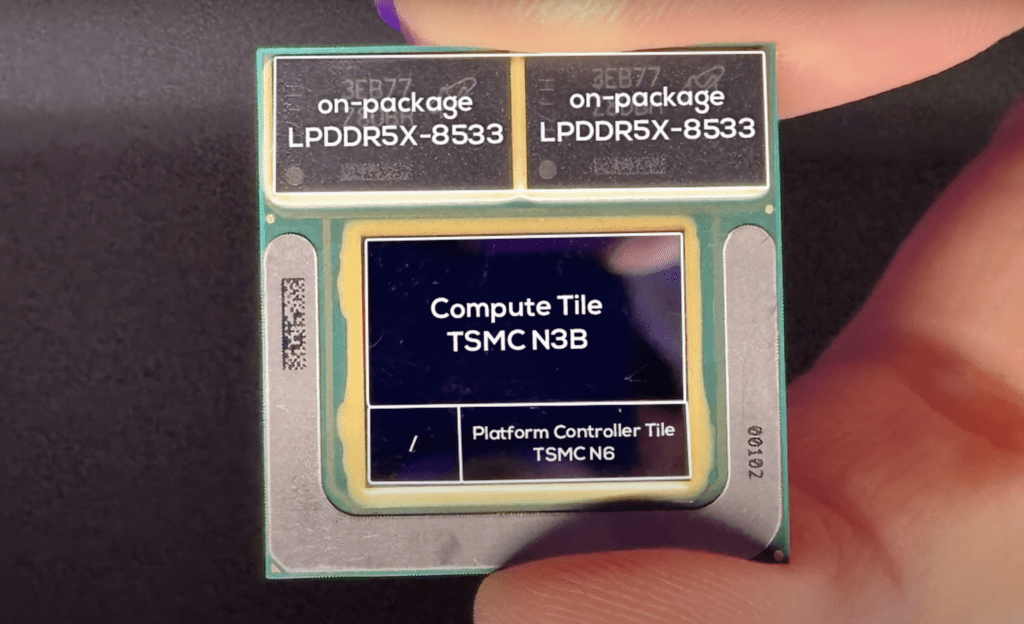

Wydaje się, że dopiero najnowsze procesory Intel Lunar Lake nieśmiało zrywają z zasadą jednego, wyżyłowanego do granic możliwości kawałka krzemu. Produkcja tych układów zlecona została TSMC, dzięki czemu według wstępnych analiz wiemy, że wykonany będzie on w co najmniej dwóch procesach technologicznych. Główna część CPU wyprodukowana zostanie w procesie N3B, czyli 3nm, natomiast mniej znaczące komponenty umieszczone zostaną w bloku N6 – 6nm. Poza tym na tym samym laminacie znalazły się też kości pamięci, co dość mocno przypomina rozwiązania Apple stosowane w ich jednostkach centralnych z serii M.

Stracony rynek GPU

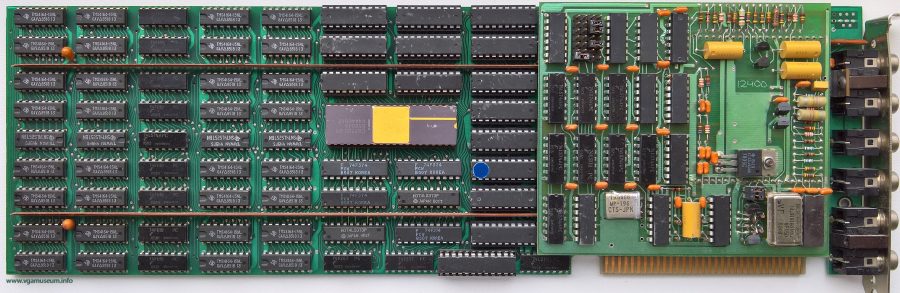

Pierwszym skojarzeniem ze słowem Intel są oczywiście procesory komputerowe i nikt raczej nie myśli o procesorach lub kartach graficznych. Jednak już w latach 80. XX wieku firma po raz pierwszy skierowała swój wzrok na rosnący rynek GPU. W tamtym czasie rynek procesorów graficznych był dość hermetyczny i skierowany we większości do profesjonalistów zajmujących się obróbką grafiki. Taki stan rzeczy utrzymywał się do 1982 roku, gdy Japońska firma NEC wprowadziła na rynek chip µPD7220, który miał być tanim procesorem graficznym dostępnym dla każdego. Intel dość szybko zauważył swoją szansę i wykupił licencję na Japoński chip. Efektem tego było dość szybkie pojawienie się amerykańskiego klona o oznaczeniu 82720 i pierwszej karty graficznej, którą z powodzeniem sprzedawano do 1986 roku.

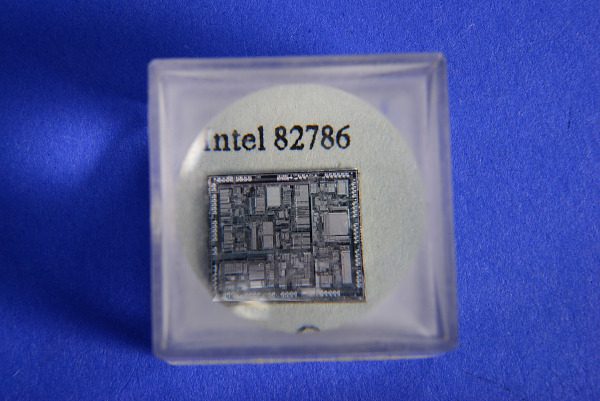

Zdobyte dzięki sprzedaży 82720 środki pozwoliły Intelowi na dalszy rozwój w dziedzinie akceleratorów graficznych. Ich efektem było pojawienie się w 1986 roku układu 82786. Był to chip w tamtych czasach dość innowacyjny. Inżynierowie niebieskich dość trafnie zauważyli, że ówczesne karty graficzne, taki jak Hitachi HD63484 czy też klony IBM EGA są duże, toporne i zbudowane z wielu dyskretnych elementów. Pomysł Intela był inny, zaprojektować pojedynczy chip, który będzie mógł w dużej mierze zastąpić ogromne obwody konkurencji. 82786 reklamowano jako przełomowy, inteligentny koprocesor graficzny o niemalże nieorganicznych możliwościach rozbudzał wyobraźnię świata technologii, ale rzeczywistość okazała się dość brutalna. Wydajność układu okazała się po prostu niezadowalająca, a jego cena zbyt wysoka, przez co to produkty konkurencji wybierane były chętniej przez twórców sprzętu komputerowego. Dlatego układ wycofano po trzech latach w 1989 roku wraz z pojawieniem się procesora 86486.

W kolejnych latach firma eksperymentowała z twórczym połączeniem klasycznego procesora z chipem graficznym. W ten sposób narodził się między innymi i860, ciekawa konstrukcja o architekturze RISC, która jednak nigdy nie zdobyła większej popularności. Tak też kończy się pierwsze podejście Intela do rynku GPU.

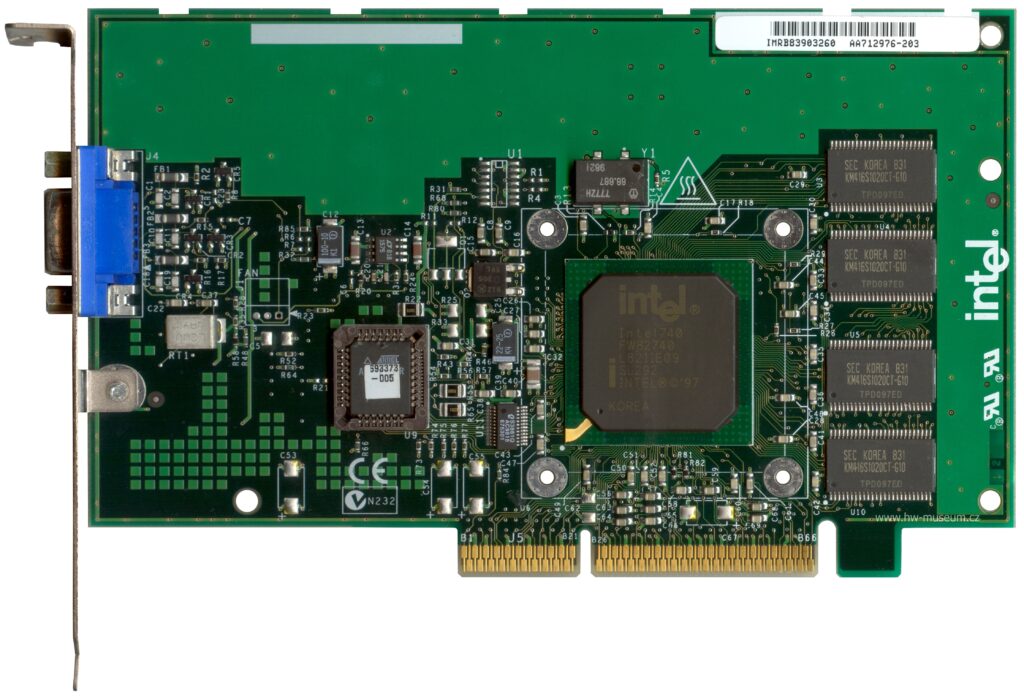

Kolejna próba zawojowania świata grafiki przez Intela również okazała się niezbyt udana. A wydana w 1998 roku karta graficzna i740 utrzymała się na rynku mniej niż rok, co było w dużej mierze efektem decyzji Lockhead Martin i szykującej się batalii prawnej między technologicznymi gigantami. Jednak na potrzeby historii musimy cofnąć się do 1995 roku.

W tamtym czasie Lockhead Martin powołuje do życia spółkę Real3D, której zadaniem było skomercjalizowanie wojskowych technologii LM związanych z grafiką. W tym celu Real3D nawiązuje współpracę z Segą i wprowadza na rynek technologię wykorzystaną w systemach Sega Model2 i Model3. Te okazują się niezwykle udane, a sprzedaż sięga ponad 200 000 sztuk. Kolejnym krokiem w historii firmy było nawiązanie współpracy z Intelem, czego efektem było pojawienie się wspomnianej wcześniej karty graficznej i740, ta jednak podobnie jak chip 82786 okazuje się rozczarowująca, przez co Lockhead Martin postanawia zakończyć projekt Real3D i wszystkie aktywa sprzedać Intelowi. Warto tutaj wspomnieć też, że spora część pracowników Real3D postanawia w tamtym czasie przejść do konkurencyjnego ATI. Jednak burza ma dopiero nadejść. To wówczas pojawia się pozew patentowy wystosowany przez 3dfx Interactive wobec Real3D, ale przez wcześniejsze przejęcie wszystkie zarzuty kierowane są przeciwko Intelowi. Zarząd niebeskich chcąc uniknąć długich i kosztownych procesów sądowych postanawia całkowicie zakończyć jakiekolwiek prace nad procesorami graficznymi. A niechciane dziecko w postaci aktywów Real3D sprzedać 3dfx’owi. Wydaje się, że Intel mógł podjąć rękawicę i kontynuować pracę nad własnym akceleratorem graficznym, bez wsparcia z Real3D, ale najwyraźniej złe doświadczenie poskutkowało prostym komunikatem „Nigdy więcej nie będziemy zajmować się procesorami graficznymi”.

Jednak mimo zapewnień z początku lat 2000., w 2008 roku podczas konferencji „Hot Chips” zaprezentowany zostaje projekt Larrabee. Ma to być nowe otwarcie na rynku kart graficznych, dzięki któremu Intel będzie mógł konkurować z najbardziej wydajnymi produktami od AMD i Nvidi. We wstępnie udostępnionych informacjach wskazywano, że chipy graficzne oparte zostaną na miniaturowych rdzeniach x86, znacznie prostszych niż tych stosowanych w klasycznych jednostkach centralnych. Poza tym podkreślano też, że każdy rdzeń będzie mógł uruchomić aż 64 wątki.

Mimo optymistycznych wizji i zapewnień w grudniu 2009 roku dowiadujemy się o anulowaniu projektu Larrabee, bez większych wyjaśnień. Efektem tego są krążące w mediach plotki o niewystarczającej wydajności nowych produktów Inteal, jak i kryzysie w strukturach zarządzania. Po kilku miesiącach, pod medialną presją firma zdecydowała się wyjaśnić, że rzeczywiście wydajność miniaturowych rdzeni x86 okazała się znacznie mniejsza, niż początkowo zakładano i właśnie dlatego projekt dedykowanej karty graficznej został anulowany.

Jednak co warto wspomnieć, prace nad Larrabee nie poszły całkowicie na marne i na ich podstawie powstał niszowy koprocesor obliczeniowy Knight’s bridge Phi.

Kolejne lata to tak naprawdę kontynuowanie prac nad zintegrowanymi procesorami graficznymi, z którymi eksperymentowano już w pierwszej dekadzie XXI wieku. Produkty te jednak nigdy nie były oczkiem w głowie Intela. Ich wydajność była lakonicznie mówiąc niewielka i do dziś pamiętam żart, w którym pytano „Do czego zintegrowany układ Intela wykorzystuje 100% swoich zasobów? Do wyświetlania pulpitu”.

Tym sposobem docieramy do czasów współczesnych i kolejnej próby Intela w przejęciu, choć części rynku procesorów graficznych. Pod koniec 2017 roku świat zadrżał na wieść o przejściu do niebieskiego zespołu Raja Koduri’ego, związanego przez wiele lat z AMD i ich rozwiązaniami graficznymi. Był to jasny sygnał, który potwierdził się niedługo później – Intel po raz kolejny podchodzi do zaprojektowania własnych kart graficznych. Marketingowo wszystko wyglądało świetnie, niesamowita wydajność, wsparcie najnowszych technologii, pełne spektrum produktów od tych budżetowych po karty dedykowane dla graczy. Jednak i tym razem wydaje się, że coś poszło nie tak, choć trzeba przyznać, że sytuacja nie wygląda tragicznie.

Pierwsze dedykowane GPU Intel ARC pojawiły się na rynku ponad rok temu i przyjęte zostały dość kiepsko, jednak nie chodziło tutaj tylko o ich wydajność, a o stabilność. Możemy wróżyć, że produkty wydane zostały nieco za wcześnie, przez co były niedopracowane. Przeglądając dzisiejsze analizy sytuacja wygląda już nieco lepiej, w swoim segmencie karty działają całkiem dobrze, choć nadal mają problemy z wydajnością i działają „w kratkę”, w części gier całkiem dobrze, w innych tragicznie. Potwierdza to poniekąd, że Intel nadal ma spore problemy ze swoimi sterownikami.

To jak rozwinie się sytuacja z Intel ARC, czas pokaże. Osobiście mocno kibicuje tutaj Intelowi, bo kierując się zasadą, że konkurencja jest dobra, trzeci gracz na rynku GPU jest czymś dobrym i jeśli niebieskim uda się przezwyciężyć tak zwane „problemy dnia pierwszego”, to być może w przyszłości zobaczymy całkiem ciekawe i wydajne urządzenia.

Konkurencyjna architektura ARM

Intel jak mało która firma związana jest z architekturą x86. Nie jest to wielkim zdziwieniem, bo jak wspominałem w historycznym wstępie, to właśnie amerykanom zawdzięczamy jej powstanie. Dziwić może jednak fakt, że przez wszystkie lata Intel nie próbował (z małymi wyjątkami) zaprojektować procesorów innych niż x86. Efektem tego jest, że firma przespała rewolucję związaną z układami ARM.

Różnic między x86 i ARM jest całkiem sporo, dlatego już jakiś czas temu przygotowałem artykuł opisujący dokładniej to zagadnienie „ARM kontra x86 – co nas czeka w przyszłości?”, do którego przeczytania zachęcam.

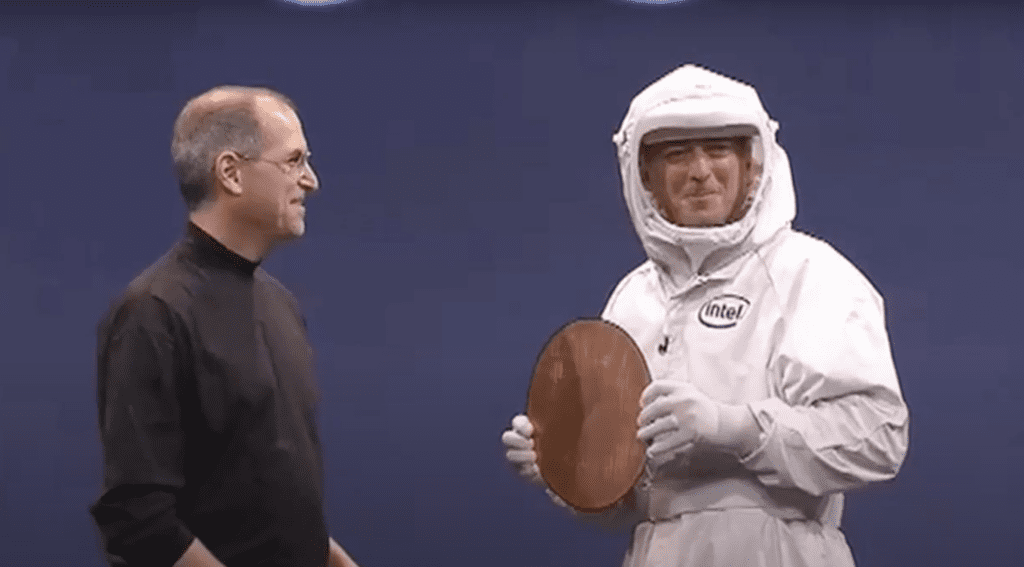

Na niekorzyść Intela wydaje się fakt, że rozwiązania sygnowane logiem ARM rozwijają się znacznie szybciej i monopol na procesory komputerowe minął bezpowrotnie. Pierwszym sygnałem było tutaj przejście firmy Apple na własne procesory w ich komputerach Mac. Co było końcem długoletniej współpracy obu firm. W ostatnim czasie również Qualcomm zaprezentował swoje pierwsze jednostki centralne dedykowane dla komputerów z Windowsem.

Architektura x86 nie zniknie z dnia na dzień, bo oba rozwiązania mają potencjał do dalszego rozwoju, choć ten dla ARM wydaje się nieco bardziej kolorowy. Dla Intela zamkniętego we własnych rozwiązaniach oznacza to problem i niechybną utratę zysków ze zdominowanego przez lata rynku procesorów. Chcąc nie chcąc firma musi postawić na rozwój.

Co się wydarzyło w 2024 roku?

Sytuację z obecnego roku można śmiało nazwać „wielowątkową katastrofą”. Przez miesiące w sieci pojawiały się informacje o niestabilności i błędach przy okazji korzystania z procesorów Intela 13 i 14 generacji. Skala problemów była na tyle duża, że spora część osób, kupująca nowe CPU zwracała je po kilku dniach, co było dość dziwne, bo procesory uchodzą za jedną z bardziej długowiecznych i bezproblemowych części w komputerze. Do całego medialnego szumu Intel odniósł się w kwietniu tego roku, informując o wszczęciu dochodzenia, mającego na celu wyjaśnienie całej sytuacji. Efektem ich prac był komunikat, że wszystkiemu winni są producenci płyt głównych, bo procesory zasilane są zbyt wysokim napięciem i to powoduje problemy. Jednocześnie wystosowany został apel, aby każdy z producentów przygotował odpowiednią aktualizację BIOS, która będzie zgodna z energetycznymi wymaganiami Intela. Tak też się stało, ale okazało się, że problem wcale nie zniknął, a dodatkowo zmniejszenie napięć spowodowało znaczny spadek wydajności.

Rozpoczęła się medialna przepychanka, w której to firmy obrzucały się wzajemnie oskarżeniami i nikt tak naprawdę nie pracował nad żadnym sensownym rozwiązaniem. Oliwy do ognia dodało studio Alderon Games, publikując w lipcu oświadczenie, mówiące wprost, że Intel sprzedaje wadliwe procesory 13 i 14 generacji.

„W ciągu ostatnich 3-4 miesięcy zaobserwowaliśmy, że procesory początkowo działające prawidłowo z czasem zaczynają mieć problemy, a ostatecznie ulegają awarii. Współczynnik awarii, który zaobserwowaliśmy w naszych testach wyniósł prawie 100% co wskazuje, że to tylko kwestia czasu zanim dotknięte problemem procesory ulegną awarii.”

Poza widocznym wyżej fragmentem w oświadczeniu mogliśmy dowiedzieć się, że firma przechodzi na procesory od AMD i zaleca to też innym użytkownikom. Na efekt domina nie trzeba było długo czekać i w kolejnych publikacjach inni twórcy również publikowali wyniki i wykresy z własnych testów, wskazujące, że rzeczywiście z procesorami Intela jest coś nie tak.

Do całej sytuacji odniósł się też Intel, który przyznał, że rzeczywiście ich najnowsze procesory są wadliwe i problem leży w napięciu zasilania. Nie jest to jednak wina producentów płyt głównych a samego procesora, który wysyła błędne żądania do sekcji zasilania powodujące wzrost napięcia. Niebiescy poinformowali też, że wydana zostanie odpowiednia aktualizacja, rozwiązująca ten problem.

Jednak mleko się już rozlało i wielu analityków wskazywało na inny problem. Procesory, które nadal działały poprawnie obarczone były wadą, przez co szybciej degradowały i nie jest pewne, czy w najbliższym czasie nie ulegną uszkodzeniu. Poza tym okazało się, że część CPU 13 generacji opuściła fabrykę z wadą konstrukcyjną, o czym poinformowała redakcja „Tech YES City”. Problem polegał na nieodpowiednim zabezpieczeniu rdzenia procesora, przez co ten ulegał stopniowemu utlenianiu, co prowadziło do jego fizycznego uszkodzenia. Z kolejnych publikacji dowiadywaliśmy się, że skala problemu może być naprawdę ogromna i dotyczyć ponad 8 milionów procesorów.

Na kolejne oświadczenie Intela nie trzeba było długo czekać i z krótkiej, lakonicznej notatki dowiedzieliśmy się, że problem ten był znany, dotyczył tylko wczesnych serii procesorów i został już wyeliminowany.

Pozostawiło to jednak sporo pytań. Dlaczego prawdopodobnie wadliwe procesory były sprzedawane? Dlaczego reklamacje składane przed medialną burzą były odrzucane, chociaż problem był firmie znany? Dlaczego informację o potencjalnych nieprawidłowościach nie pojawił się wcześniej? Dlaczego firma nie poinformuje wprost, które wczesne serie procesorów dotknięte były wadą utleniania?

Wydaje się, że Intel postanowił zagrać tutaj kartą wadliwego mikrokodu procesora, który można naprawić aktualizacją. I takie właśnie miało być wytłumaczenie wszystkich problemów. Jednak nikt nie zdawał sobie sprawy, że światło dzienne ujrzą informacje o utlenianiu, których nie da się naprawić inaczej, niż wymieniając wadliwe CPU.

Winny całej sytuacji jest tylko i wyłącznie Intel i chcąc, nie chcąc firma będzie teraz ponosić wszystkie koszty zaistniałej sytuacji, a te już teraz są dość spore.

Konsekwencje nie tylko wizerunkowe

Cała sytuacja związana z Intelem ma konsekwencje nie tylko wizerunkowe. Poza zawiedzeniem konsumentów firma boryka się ze znacznym spadkiem sprzedaży i przejściem wielu użytkowników na rozwiązania konkurencji. Nie ukrywając, sam jestem jednym z nich, przez lata pracowałem na układach Intela, ale zmieniając jakiś czas temu komputer, zdecydowałem się na procesor od AMD.

Sporym problemem okazały się też finanse, wycena akcji firmy spadła w ostatnim czasie o około 25% co poskutkowało miliardowymi stratami z kapitalizacji. Niestety reakcja zarządu Intela mogła być tylko jedna – głęboka restrukturyzacja i wstrzymanie inwestycji. Na początku sierpnia ogłoszono redukcję o około 15%, co oznacza, że pracę straci blisko 15 000 osób. Niedługo po tym poinformowano też o wstrzymaniu wszystkich zagranicznych inwestycji, w tym budowy zakładu, który miał powstać pod Wrocławiem.

Cóż, jaka będzie przyszłość, czas pokaże, szczerze mówiąc wątpię we wróżony przez wielu upadek lub przejęcie przez Qualcomm, cytując tutaj Pana Grzegorza Kamińskiego, jednego ze specjalistów branży półprzewodnikowej – „Po co firma fabless (która nie ma fabryk) miałaby kupić taką, która zatrudnia ponad 100 000 pracowników i ma aż 19 fabryk + 4 w budowie.” Sytuacja jest rozwojowa, Intel w swojej historii przeżył wiele kryzysów i nietrafionych inwestycji, poza tym stoi przed nią wiele wyzwań i czas pokaże czy wróci ona silniejsza.

Źródła:

- https://timeline.intel.com/2009/sponsors-of-tomorrow

- https://timeline.intel.com/1969/the-1101

- https://timeline.intel.com/1969/intel’s-first-sale

- https://spectrum.ieee.org/chip-hall-of-fame-intel-4004-microprocessor

- https://timeline.intel.com/1997/meet-the-bunny-people

- https://www.youtube.com/watch?v=ba5w8rKwd_c

- https://www.computer.org/publications/tech-news/chasing-pixels/intels-gpu-history

- https://americanhistory.si.edu/collections/object/nmah_1388717

- https://www.businessinsider.com/intel-shareholders-lawsuit-foundry-business-chips-layoffs-2024-8?IR=T

- https://brightsideofnews.com/blog/an-inconvenient-truth-intel-larrabee-story-revealed/

- https://www.youtube.com/watch?v=uknCpuFaOfQ

- https://www.jagatreview.com/2024/08/intel-arc-a760a-diskrit-gpu-mobil/

- https://mikrokontroler.pl/2024/09/23/grzegorz-kaminski-moje-3-grosze-w-dyskusji-o-decyzjach-firmy-intel-i-jej-pozycji-rynkowej/

Jak oceniasz ten wpis blogowy?

Kliknij gwiazdkę, aby go ocenić!

Średnia ocena: 5 / 5. Liczba głosów: 9

Jak dotąd brak głosów! Bądź pierwszą osobą, która oceni ten wpis.